Auf LLMs (Large Language Models) basierende GenAI-Apps bergen enormes Potenzial für die verschiedensten Branchen. Die Kehrseite der Medaille ist, dass das Entwickeln, Deployment und Monitoring solch leistungsstarker Modelle ein höchst komplexes Unterfangen ist. Daher haben sich NVIDIA und New Relic zusammengeschlossen, um diese Aufgaben für KI-gestützte Enterprise-Apps in Produktionsumgebungen zu vereinfachen.

NVIDIA NIM bietet als Teil von NVIDIA AI Enterprise eine Reihe cloudnativer Microservices, die Modelle in Form optimierter Container bereitstellen. Diese lassen sich in Clouds, Rechenzentren oder Workstations einsetzen, um die Entwicklung von GenAI-Apps wie Copilots und Chatbots zu erleichtern.

Durch die nahtlose Integration von New Relic AI Monitoring und NVIDIA NIM erhalten Kunden Full-Stack-Observability für Anwendungen, die eine Vielzahl von NIM-unterstützten KI-Modellen nutzen, darunter Meta Llama 3, Mistral Large und Mixtral 8x22B. Unternehmen können dank dieser Integration guten Gewissens KI-Apps auf Basis von NVIDIA NIM bereitstellen und überwachen, die Time-to-Market beschleunigen und den ROI verbessern.

Was ist NVIDIA NIM?

NVIDIA NIM bezeichnet ein Sortiment von Inferenz-Microservices, mit dem Kunden fertige, optimierte LLM-Modelle für das vereinfachte Deployment über eine NVIDIA-beschleunigte Infrastruktur im Rechenzentrum und in der Cloud nutzen können. So müssen Unternehmen nicht mehr wertvolle Zeit und Ressourcen darauf verwenden, Modelle für die Ausführung in unterschiedlicher Infrastruktur zu optimieren, APIs zur Erstellung von Apps zu schaffen und die Sicherheit und den Support für diese Modelle in einer Produktionsumgebung zu gewährleisten. NIM packt die Herausforderungen generativer KI an der Wurzel:

- Optimierte, einsatzfertige Modelle: Mit einer vollständigen Bibliothek fertig trainierter LLM-Modelle sparen Sie sich die Mühe und den Personalaufwand für die Modellentwicklung. Da die Modelle für NVIDIA-GPUs optimiert sind, sind Effizienz und hohe Leistung garantiert.

- Vereinfachtes Deployment: Durch den Einsatz containerisierter Microservices ist die Bereitstellung im Nu erledigt. In den einsatzbereiten Modellen ist alles enthalten, was Sie für die Ausführung brauchen. So können Sie sich auf rasches Deployment auf den verschiedensten Plattformen freuen – ob Cloudumgebung oder On-Premise-Rechenzentrum.

- Einfach sicherer: Die Möglichkeit zur Modellimplementierung mit eigenem Host gewährt Ihnen besonders bei Apps mit hohen Sicherheitsanforderungen vollständige Kontrolle über Ihre Daten.

Erste Schritte mit New Relic AI Monitoring für NVIDIA NIM

New Relic AI Monitoring unterstützt den gesamten KI-Stack für Anwendungen, die mit NVIDIA NIM entwickelt wurden, mit den Vorteilen von Full-Stack-Observability. Somit können Sie das Monitoring, Debugging und Optimieren Ihrer KI-Apps hinsichtlich Leistung, Qualität und Kosten problemlos durchführen und gleichzeitig Datenschutz und maximale Sicherheit gewährleisten. Folgen Sie dieser schrittweisen Anleitung für das Monitoring von KI-Apps, die mit NVIDIA NIM entwickelt wurden.

Schritt 1: Instrumentieren Sie Ihre mit NVIDIA NIM entwickelte KI-App

An erster Stelle steht die Instrumentierung Ihrer App. Das geht so:

- Registrieren Sie sich für ein kostenloses New Relic Konto bzw. melden Sie sich an, wenn Sie bereits ein Konto angelegt haben.

- Klicken Sie auf Add Data.

- Geben Sie in der Suchleiste NVIDIA ein und wählen Sie NVIDIA NIM aus.

- Wählen Sie die Programmiersprache Ihrer App (Python, Node.js) aus.

- Führen Sie die Anleitungsschritte von New Relic zum Onboarding aus. Damit erfolgt die Instrumentierung Ihrer mit NVIDIA NIM entwickelten KI-App. Die Demo-App trägt den Namen „local-nim“.

Schritt 2: Rufen Sie AI Monitoring auf

Nach der Instrumentierung der App sind Sie bereit, das AI Monitoring zu nutzen:

- Gehen Sie in Ihrem New Relic Dashboard zu All Capabilities.

- Klicken Sie auf AI Monitoring.

- Im Bereich „AI Monitoring“ sehen Sie unter All Entities die mit NVIDIA NIM entwickelte Demo-App „local-nim“.

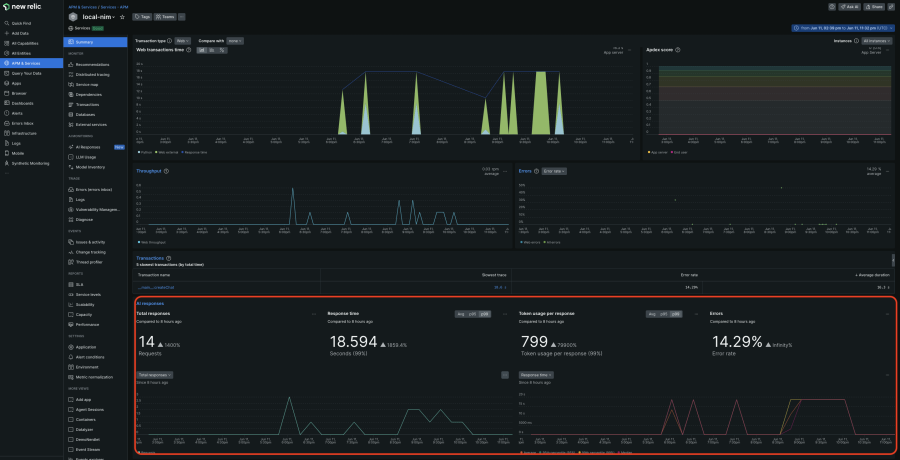

- Klicken Sie auf die App „local-nim“, um auf die APM 360 Übersicht mit integrierter AI Monitoring Ansicht zuzugreifen. Diese zentrale Ansicht liefert Ihnen sofortige Einblicke in die wichtigsten Metriken der KI-Ebene, z. B. die Gesamtanzahl der Anfragen, durchschnittliche Antwortzeit, Tokennutzung und Antwortfehlerquoten zusammen mit goldenen APM-Signalen, Einblicken in die Infrastruktur und Logs. Durch Korrelieren all dieser Informationen an einem Ort können Sie das Problem rasch identifizieren und einen Drill-down zur weiteren Analyse durchführen.

Schritt 3: Verschaffen Sie sich umfassende Einblicke durch Response-Tracing der KI-Antworten

Die Deep-Tracing-Ansicht ist für ausführliche Analysen höchst aufschlussreich:

- Klicken Sie links in der Übersicht zu APM 360 auf AI Responses und wählen Sie die Antwort aus, zu der Sie mehr erfahren möchten.

- Hier sehen Sie den gesamten Werdegang der KI-Antworten von der ersten Benutzereingabe bis zur letzten Antwort sowie Metadaten wie Tokenzahl, Modellinformationen und tatsächliche Benutzerinteraktionen. So können Sie jedes Problem schnell auf seine Ursache hin zurückverfolgen.

Schritt 4: Sehen Sie sich das Modellinventar an

Das Modellinventar bietet einen umfassenden Überblick über die Verwendung der jeweiligen Modelle in allen Services und Konten. So können Sie modellspezifische Probleme im Hinblick auf Leistung, Fehler oder Kosten leicht identifizieren.

- Kehren Sie zurück zum Bereich „AI Monitoring“.

- Klicken Sie auf Model Inventory, um modellspezifische Daten zu Leistung, Fehlern und Kosten einzusehen.

Schritt 5: Vergleichen Sie Modelle, um die richtige Wahl zu treffen

So wählen Sie das Modell aus, das Ihren Bedürfnissen im Hinblick auf Kosten und Performance am besten entspricht:

- Klicken Sie auf Compare Models.

- Wählen Sie in der Dropdown-Liste die Modelle, Services und Zeitfenster aus, die Sie gegenüberstellen möchten.

Schritt 6: Optimieren Sie Sicherheit und Datenschutz

New Relic erweitert die bereits umfassende Sicherheit des selbstgehosteten NVIDIA-NIM-Modells durch die Möglichkeit, vertrauliche personenbezogene Daten in Ihren KI-Anfragen und -Antworten aus dem Monitoring auszuschließen:

- Klicken Sie auf Drop Filters und legen Sie Filter für spezifische Datentypen innerhalb der sechs aufgeführten Events an.

Beschleunigter KI-Einsatz in der Produktionsumgebung dank New Relic und NVIDIA

New Relic AI Monitoring und NVIDIA NIM bieten gemeinsam eine überzeugende Lösung für Unternehmen, die Wert auf den beschleunigten Einsatz von KI in einer Produktionsumgebung legen. Durch einsatzbereite Modelle, effizientes Deployment und umfassendes Monitoring werden Unternehmen in die Lage versetzt, leistungsstarke GenAI-Apps schneller bereitzustellen. So lassen sich nicht nur erhebliche Einsparungen erzielen, sondern auch der ROI ist schneller erreicht. Dieses gemeinsame Angebot stellt einen wichtigen Schritt bei der Demokratisierung des KI-Zugangs und dem Ausschöpfen des transformativen Potenzials der Technologie dar.

Richten Sie sich ein kostenloses New Relic Konto ein und legen Sie direkt mit dem Monitoring Ihrer NVIDIA-NIM-Anwendungen los.

Die in diesem Blog geäußerten Ansichten sind die des Autors und spiegeln nicht unbedingt die Ansichten von New Relic wider. Alle vom Autor angebotenen Lösungen sind umgebungsspezifisch und nicht Teil der kommerziellen Lösungen oder des Supports von New Relic. Bitte besuchen Sie uns exklusiv im Explorers Hub (discuss.newrelic.com) für Fragen und Unterstützung zu diesem Blogbeitrag. Dieser Blog kann Links zu Inhalten auf Websites Dritter enthalten. Durch die Bereitstellung solcher Links übernimmt, garantiert, genehmigt oder billigt New Relic die auf diesen Websites verfügbaren Informationen, Ansichten oder Produkte nicht.