Kleine Katastrophen kommen vor.

So reagieren Sie am besten, um die Auswirkungen zu minimieren.

Unwichtige Alerts braucht kein Mensch.

Es macht keinen Spaß, morgens um 3 von Alerts aufgeweckt zu werden. Vor allem, wenn sie nicht geschäftskritisch sind. Daher ist es sinnvoll, Alerts auf Probleme zu filtern, die sich direkt auf Kund:innen und Ihr Geschäft auswirken. Filtern Sie Probleme nach Typ, Verstoß, betroffenen Services und anderen Variablen, um hohem Alert-Volumen ein Ende zu bereiten und stattdessen hochwertige Benachrichtigungen zu erhalten. So erhält Ihr Team wirklich relevante Alerts und kann auf Incidents reagieren, statt durch Rauschen abgelenkt zu sein.

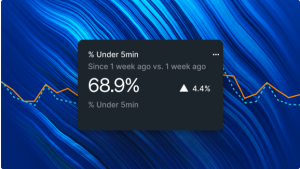

Weniger Flapping, schnelleres Handeln.

Flapping-Alerts werden innerhalb von fünf Minuten ausgegeben und wieder geschlossen – und sind der primäre Grund für Alert-Fatigue. Durch hochwertige Alerts, bei denen Probleme mit dazugehörigen Deployments, Fehlern und anderen Incidents korreliert werden können, sind Sie sofort über den Umfang des Incidents im Bilde. Und mit ITSM-Software wie ServiceNow, PagerDuty, SMS und anderen sind Sie nicht nur über den Kontext informiert, sondern können diese Infos auch direkt mit Ihrem gesamten Team teilen. SRE-Teams können Sie dabei wöchentliche Berichte über die Alert-Qualität senden, um die Entwicklungsarbeit zu beschleunigen.

Geschäftskritische Probleme? Dafür sind Alerts gemacht.

Wenn keine Kund:innen von einem Problem betroffen sind, ist es vielleicht nicht so dringend. Konzentrieren Sie Ihre Alerts auf Metriken, die Sie benachrichtigen, wenn ein geschäftskritischer Vorfall auftritt. Unser Feature für Anomalie-Erkennung erkennt automatisch ungewöhnliche Verhaltensmuster in allen Anwendungen, Services und Log-Daten. Für Sie bedeutet das weniger Arbeit und gleichzeitig geringeres Risiko durch weniger Downtime und negative Auswirkungen. Damit Ihre Kund:innen online bleiben und Ihr Geschäft auf Kurs bleibt.

Sehen Sie, wie Kunden Alerts fokussieren – um Probleme schneller zu identifizieren.

FAQs zur Alert-Qualität

Folgende Szenarien erleben wir häufig:

- Statt Ihrer Observability-Plattform weisen Kunden Sie auf Probleme hin, die sich auf Ihr Geschäft auswirken.

- Dringende Alerts gehen im Alert-Rauschen unter.

- Probleme treten immer wieder auf – und werden dennoch nie wirklich behoben.

A: Eine Alert-Schwemme liegt vor, wenn einfach zu viele Alerts und Benachrichtigungen eingehen. Das führt zur Ermüdung. Die zuständigen Teams verlieren das Vertrauen in die Validität von Alerts und fangen an, diese zu ignorieren. Schlussendlich gehen wichtige Probleme im Rauschen unter.

Alerts, die lange Zeit (einen Tag lang, eine Woche lang) offen bleiben. Ebenso Flapping-Alerts – Alerts, die innerhalb von fünf Minuten geöffnet und wieder geschlossen werden.

Hochwertige Alerts regen engagiertes Handeln an.