Las aplicaciones de IA generativa basadas en modelos de lenguaje extenso (LLM) encierran un inmenso potencial en diversos sectores. Sin embargo, construir, desplegar y monitorear estos potentes modelos es un proyecto complejo. Aquí es donde NVIDIA y New Relic unen sus fuerzas para proporcionar una ruta simplificada para desarrollar, desplegar y monitorear aplicaciones empresariales impulsadas por IA en producción.

NVIDIA NIM, parte de NVIDIA AI Enterprise, es un conjunto de microservicios nativos de la nube que ofrecen modelos como contenedores optimizados. Estos contenedores pueden desplegarse en nubes, centros de datos o estaciones de trabajo, lo que permite crear fácilmente aplicaciones de IA generativa como copilotos y chatbots.

El monitoreo New Relic AI se integra a la perfección con NVIDIA NIM, proporcionando observabilidad de todo el stack para aplicaciones creadas en una amplia gama de modelos de IA compatibles con NIM, incluidos Llama 3 de Meta, Mistral Large y Mixtral 8x22B, entre otros. Esta integración ayuda a las organizaciones a desplegar y monitorear con confianza las aplicaciones de IA construidas con NVIDIA NIM, acelerar el tiempo de comercialización y mejorar el retorno de la inversión.

¿Qué es NVIDIA NIM?

NVIDIA NIM es un conjunto de microservicios de inferencia que proporciona modelos LLM preconstruidos y optimizados, lo que simplifica el despliegue en la infraestructura acelerada de NVIDIA en el centro de datos y la nube. Esto elimina la necesidad de que las empresas dediquen tiempo y recursos valiosos a optimizar los modelos para que se ejecuten en distintas infraestructuras, crear API para que los desarrolladores creen aplicaciones y mantener la seguridad y el soporte de estos modelos en producción. Así es como NIM aborda los retos de la IA generativa:

- Modelos preconstruidos y optimizados: NIM ofrece una biblioteca de modelos de LLM preentrenados, lo que te ahorra el esfuerzo y la experiencia necesarios para el desarrollo de modelos. Estos modelos están optimizados específicamente para las GPU NVIDIA, lo que garantiza un rendimiento eficiente.

- Despliegue simplificado: NIM utiliza microservicios en contenedores, haciendo que el despliegue sea muy sencillo. Estas unidades pre-empaquetadas incluyen todo lo necesario para ejecutar el modelo, permitiendo un despliegue rápido y fácil en varias plataformas, desde entornos en la nube hasta centros de datos locales.

- Seguridad mejorada: Para aplicaciones que requieren una seguridad robusta, la opción de despliegue de modelos autohospedados de NIM proporciona control completo sobre tus datos.

Primeros pasos con el Monitoreo New Relic AI para NVIDIA NIM

El monitoreo New Relic AI ofrece el poder de la observabilidad a todo el stack de IA para aplicaciones creadas con NVIDIA NIM. Esto te permite monitorear, depurar y optimizar sin esfuerzo tus aplicaciones de IA en cuanto a rendimiento, calidad y costo, mientras garantizas la privacidad y seguridad de los datos. Aquí tienes instrucciones paso a paso para empezar a monitorear aplicaciones de IA creadas con NVIDIA NIM

Paso 1: Instrumenta tu aplicación de IA creada con NVIDIA NIM

Primero, debes configurar la instrumentación de tu aplicación. Así es cómo se hace:

- Regístrate para obtener una cuenta gratuita de New Relic o inicia sesión si ya tienes una.

- Haz clic en Agregar datos.

- En la barra de búsqueda, escribe NVIDIA y selecciona NVIDIA NIM.

- Elige el lenguaje de programación de tu aplicación (Python, Node.js).

- Sigue el proceso guiado de integración que brinda New Relic. Este proceso te guiará a través de la instrumentación de tu aplicación de IA construida con NVIDIA NIM. Hemos llamado a nuestra aplicación de ejemplo "local-nim".

Paso 2: Accede al monitoreo de IA

Una vez que tu aplicación esté instrumentada, puedes empezar a utilizar el monitoreo de IA:

- Ve a Todas las capacidades en tu panel de control de New Relic.

- Haz clic en Monitoreo de IA.

- En la sección Monitoreo de IA, en Todas las entidades, verás la aplicación de ejemplo "local-nim" que hemos creado utilizando NVIDIA NIM.

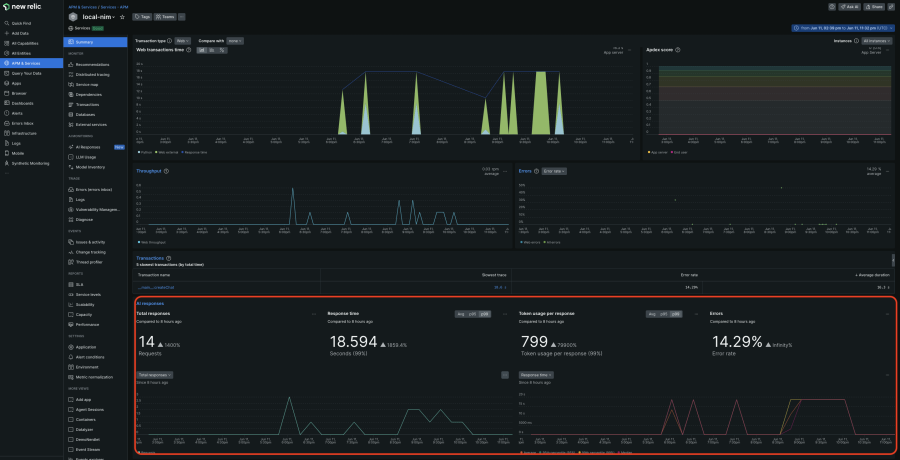

- Haz clic en la aplicación local-nim para acceder al resumen de APM 360 con la vista de monitoreo de IA integrada. Esta vista unificada te proporciona información instantánea sobre las métricas clave de la capa de IA, como el número total de solicitudes, el tiempo promedio de respuesta, el uso de tokens y las tasas de errores de respuesta. Estos resultados aparecen en contexto, junto con las señales doradas del APM, la información sobre la infraestructura y los logs. Al correlacionar toda esta información en un solo lugar, puedes identificar rápidamente el origen de los problemas y profundizar en el análisis.

Paso 3: Profundiza con el rastreo de respuestas de IA

Para un análisis más detallado, la vista de rastreo profundo es increíblemente útil:

- En el resumen de APM 360, haz clic en la navegación Respuestas de IA de la izquierda y selecciona la respuesta en la que deseas profundizar.

- Aquí puedes ver toda la ruta desde la entrada inicial del usuario hasta la respuesta final, incluidos metadatos como el recuento de tokens, la información del modelo y las interacciones reales del usuario. De este modo, podrás determinar rápidamente la causa del problema.

Paso 4: Explora el inventario de modelos

El inventario de modelos proporciona una visión completa del uso de los modelos en todos sus servicios y cuentas. Esto te ayuda a aislar cualquier problema de rendimiento, error o costo relacionado con el modelo.

- Regresa a la sección de Monitoreo de IA.

- Haz clic en Inventario de modelos y visualiza las métricas de rendimiento, errores y costos por modelos

Paso 5: Compara modelos para una elección óptima

Para elegir el modelo que mejor se ajuste a tus necesidades de costo y rendimiento:

- Haz clic en Comparar modelos

- Selecciona los modelos, el servicio y los intervalos de tiempo que deseas comparar en la lista desplegable

Paso 6: Mejora la privacidad y la seguridad

Complementando la robusta ventaja de seguridad de los modelos autohospedados de NVIDIA NIM, New Relic te permite excluir el monitoreo de datos sensibles (PII) en tus solicitudes y respuestas de IA:

- Haz clic en Filtros de eliminacióny crea filtros destinados a tipos de datos específicos dentro de los seis eventos ofrecidos.

Aceleración de la IA en la producción con New Relic y NVIDIA

El monitoreo New Relic IA y NVIDIA NIM ofrecen una solución convincente para las organizaciones que buscan acelerar la IA en producción. Al aprovechar los modelos preconstruidos, el despliegue simplificado y el monitoreo integral, las empresas pueden ofrecer aplicaciones de IA generativa de alto rendimiento con mayor rapidez, lo que resulta en ahorros significativos de costos y un camino más rápido hacia el retorno de inversión (ROI). Esta colaboración marca un paso significativo hacia la democratización del acceso a la IA y su potencial transformador.

Regístrate para obtener una cuenta gratuita de New Relic y empieza a monitorear tus aplicaciones NVIDIA NIM hoy mismo.

Las opiniones expresadas en este blog son las del autor y no reflejan necesariamente las opiniones de New Relic. Todas las soluciones ofrecidas por el autor son específicas del entorno y no forman parte de las soluciones comerciales o el soporte ofrecido por New Relic. Únase a nosotros exclusivamente en Explorers Hub ( discus.newrelic.com ) para preguntas y asistencia relacionada con esta publicación de blog. Este blog puede contener enlaces a contenido de sitios de terceros. Al proporcionar dichos enlaces, New Relic no adopta, garantiza, aprueba ni respalda la información, las vistas o los productos disponibles en dichos sitios.