Die Welt der KI entwickelt sich rasend schnell. Leistungsstarke neue KI-Modelle wie Sora, Mistral Next und Gemini 1.5 Pro verschieben die Grenzen des Möglichen, und natürlich möchten Unternehmen diese Neuentwicklungen für sich oder vielmehr für die Entwicklung bahnbrechender Anwendungen für ihr Kundschaft nutzen.

Bei New Relic ist uns das immense Potenzial, das die generative KI birgt, nicht neu. Deshalb haben wir New Relic AI entwickelt – eine GenAI-Lösung zur Demokratisierung von Observability. Die Erfahrungen, die wir bei der Entwicklung von New Relic AI sammeln konnten, machten allerdings deutlich, welche Herausforderungen diese Technologie mit sich bringt und wie wichtig zuverlässige KI-Monitoring-Lösungen sind. Die logische Folgerung war New Relic AI Monitoring: die branchenweit erste Lösung fürs Application Performance Monitoring (APM) für KI, die den gesamten KI-Anwendungsstack offenlegt.

Aber New Relic AI Monitoring ist nicht nur für uns gedacht – sondern für alle! Wir möchten, dass sich Unternehmen jeder Größe zuversichtlich in das Abenteuer namens KI stürzen können. Deshalb freuen wir uns, jetzt die allgemeine Verfügbarkeit von New Relic AI Monitoring bekannt zu geben. Mit diesem neuesten der über dreißig Toolsets von New Relic können Sie Ihre KI-Anwendungen mühelos auf Performance, Qualität und Kosten überwachen, managen und optimieren.

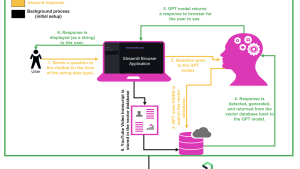

In diesem Blogpost sehen wir uns anhand eines einfachen, mit OpenAI-LLMs und LangChain entwickelten Chatservices an, was New Relic AI Monitoring alles kann. Wir gehen die verschiedenen Funktionen durch und zeigen Ihnen, wie Sie es zum Debugging von Fehlern in den Antworten Ihrer KI-Anwendung einsetzen können.

Müheloses Instrumentieren und Onboarding

Dank der automatischen Instrumentierung lässt sich New Relic AI Monitoring denkbar einfach und intuitiv in Ihre Workflows integrieren. Für beliebte KI-Frameworks wie OpenAI oder Amazon Bedrock ermöglichen unsere Agents eine mühelose Instrumentierung über Python, Node.js, Ruby, Go und .NET. Bei der Installation werden Sie in wenigen Mausklicks durch die Instrumentierung für das Monitoring Ihrer Chatanwendung geführt, damit Sie Ihre KI-Anwendungen von Anfang an umfassend überwachen können.

So geht die Instrumentierung für unseren einfachen Chatservice:

- Gehen Sie in New Relic zu Add Data und wählen Sie dort AI Monitoring aus.

- Wählen Sie dann unter AI Monitoring das gewünschte Framework aus, z. B. OpenAI Observability.

- Schließlich wählen Sie noch den Instrumentierungs-Agent, in diesem Fall ist das Python, und folgen dann einfach der leicht verständlichen Anleitung zur Instrumentierung.

Hilfreiche Infos zur Modellnutzung. Ohne Umschweife.

Management und Optimierung von KI-Modellen sind komplexe Unterfangen, die allerdings durch das AI Model Inventory erheblich vereinfacht werden, denn es bietet einen zentralen Überblick über Ihre gesamte Modellnutzung. Dank vollständiger Einsicht in die wichtigsten Metriken all Ihrer Modelle können Sie mit diesem Modellinventar mühelos Probleme hinsichtlich Performance, Fehlerrate oder Kosten isolieren.

So verwenden Sie das AI Model Inventory:

- Gehen Sie in New Relic zu AI Monitoring.

- Klicken Sie im Toolsetbereich auf Model Inventory.

- Im Tab Overview finden Sie eine Übersicht aller Anfragen, Antwortzeiten, Tokennutzung, Vervollständigungen und Fehlerquoten Ihrer Modelle für alle Services und Konten. Klicken Sie in der Vervollständigungstabelle auf eine beliebige Vervollständigung, um die Deep-Trace-Ansicht aufzurufen. Dort wird Ihnen der gesamte Verlauf von der Anfrage bis zur Antwort angezeigt.

- Klicken Sie auf den Tab Errors, um Fehler in allen Modellen aufzurufen. So sehen Sie sofort, welche Fehler am häufigsten vorkommen sowie welche Modelle die höchste Fehlerquote aufweisen, und können Fehler effizient diagnostizieren und rascher beheben.

- Klicken Sie als Nächstes auf den Tab Performance, um die Gesamtanzahl der Anfragen und Antwortzeiten der einzelnen Modelle zu sehen. Auf diese Weise lassen sich leistungsschwache Modelle schnell ermitteln und optimieren.

- Klicken Sie auf den Tab Cost, um die Tokennutzung pro Modell sowie die Prompt- und Vervollständigungs-Tokennutzung pro Modell und damit eventuelle Einsparungsmöglichkeiten zu sehen.

- Verwenden Sie Datenfilter, um Ihre Analyse nach Service, Anfrage oder Antwort einzugrenzen. Diese Funktion liefert Ihnen genauere Einblicke und ermöglicht eine maßgeschneiderte Analyse, was Ihnen letztendlich das Management und die Optimierung Ihrer KI-Modelle erleichtert.

Mithilfe von AI Model Inventory sorgen Sie dafür, dass Ihre KI-Modelle optimale Leistung liefern sowie zuverlässig und kosteneffektiv funktionieren, denn nur so können sie eine solide Grundlage all Ihrer KI-Initiativen bilden.

Full-Stack Visibility für KI-Anwendungen

Sobald Ihre KI-Anwendung instrumentiert ist, liefert Ihnen New Relic AI Monitoring beispiellose Einblicke in Performance und Ausführung und lässt sich im Gegensatz zum herkömmlichen Application Performance Monitoring (APM) sogar nahtlos in APM 360 integrieren. Damit erhalten Sie einen konsolidierten Überblick über Ihr gesamtes KI-Ökosystem, mit den üblichen APM-Metriken (Antwortzeit, Throughput, Fehlerquote) und zusätzlich mit KI-spezifischen Metriken, die zur Optimierung Ihrer KI-Anwendung unverzichtbar sind, z. B. Gesamtanzahl der Anfragen, durchschnittliche Antwortzeit und Tokennutzung. All dies ermöglicht ein effektives Monitoring Ihrer gesamten KI-Umgebung über eine zentrale Oberfläche.

Sehen wir uns das einmal für den Chatservice in Aktion an.

- Gehen Sie in New Relic zu AI Monitoring.

- Klicken Sie auf AI Entity und wählen Sie Ihren Chatservice.

- In der Übersicht werden die anwendungsrelevanten sowie die KI-spezifischen Metriken nebeneinander angezeigt.

Im KI-Antwort-Widget in der Übersicht sehen Sie, dass der Service insgesamt 2.830 Antworten verarbeitet hat, und zwar mit einer durchschnittlichen Antwortzeit von 7,1 Sekunden sowie einer durchschnittlichen Tokennutzung von 858 Token pro Antwort.

Rasche Ermittlung von Ausreißern bei KI-Antworten

New Relic AI Monitoring macht die Analyse von KI-Antworten zum Kinderspiel. In der konsolidierten Antwortansicht lassen sich Ausreißer und Trends bei LLM-Antworten schnell erkennen, sodass Sie entsprechende Feineinstellungen an Ihrer Anwendung vornehmen können, um Performance, Qualität und Kosten zu optimieren.

Hier lassen sich Feedback und Sentiment für jede KI-Antwort analysieren. Zusätzlich können Sie nach verschiedenen Kriterien filtern, z. B. Anfrage, Antwort, Fehler usw.

Die KI-Antwortansicht können Sie auf zwei Arten aufrufen:

- Von der Serviceübersicht aus: Klicken Sie auf das Widget AI Response, um eine detaillierte Ansicht aufzurufen.

- Globale Ansicht: Wenn Sie auf das Haupt-Navigationselement AI Response klicken, erhalten Sie eine konsolidierte Ansicht aller KI-Entities.

Für den Chatservice klicken wir in der Übersicht auf das Widget „AI Response“. Auf der Seite „AI Response“ können wir dann nach Fehlern filtern und uns diejenigen KI-Antworten ansehen, die für den Chatservice einen Fehler enthalten.

Wenn Sie auf eine der KI-Antworten mit einem Fehler klicken, gelangen Sie zur Response-Tracing-Ansicht, wo Sie weiter nach der Fehlerursache forschen können.

Schnellere Ursachenfindung dank Deep-Tracing

Mit New Relic AI Monitoring hat die Raterei beim Debugging komplexer KI-Anwendungen ein Ende, denn unsere Response-Tracing-Ansicht zeigt Ihnen den gesamten Verlauf Ihrer KI-Anfrage – vom ersten Benutzerprompt bis hin zur endgültigen Antwort. Zusätzlich erfasst New Relic AI Monitoring verschiedene mit jeder Anfrage verknüpfte Metadaten. Durch Klicken auf Spans haben Sie Zugriff auf Metadaten wie Tokenanzahl und Modellinformationen, und Sie können den Nachrichtenverlauf während der Modellaufrufe sehen. All dies ermöglicht hochpräzises Debugging.

Unsere Integration für LangChain ermöglicht das Tracing Schritt für Schritt und zeigt genau, wie die Inputs in den verschiedenen KI-Komponenten verarbeitet und wie die Outputs generiert werden. Für das Troubleshooting komplexer KI-Anwendungen sind diese detaillierten Debugging-Features ein Geschenk des Himmels.

Sie erinnern sich an das Fehlerszenario in unserem Chatservice? Wenn Sie auf den problematischen Span im Trace klicken, sehen Sie detaillierte Fehlerinformationen. So können Sie die grundlegende Ursache des Problems umgehend diagnostizieren und beheben und Ihre KI-Anwendung in kürzester Zeit wieder ans Laufen bringen.

Optimierung von Performance und Kosten für alle Modelle

Die Auswahl des passenden KI-Modells für Ihre Anwendung ist wichtig. Aber woher wissen Sie, dass Sie aus dem immer größer werdenden Angebot das richtige auswählen? New Relic AI Monitoring kann dabei helfen, und zwar mit einem KI-Modellvergleich, der Ihnen einen Überblick über die Performance- und Kostenunterschiede zwischen den verschiedenen KI-Modellen liefert. So haben Sie die Gewissheit, dass Sie genau das für Sie passende Modell wählen.

Für die simple Chatanwendung können Sie den KI-Modellvergleich mit ein paar Mausklicks aufrufen:

- Gehen Sie in New Relic zu AI Monitoring.

- Klicken Sie im Toolsetbereich auf Compare Models.

- Wählen Sie die Modelle aus, die Sie vergleichen möchten, z. B. GPT-4 und Bedrock.

- Wenn Sie auf See the comparison klicken, sehen Sie den detaillierten Vergleich und können auf dieser Basis das für Ihren Chatservice passende Modell wählen.

Verbesserung von Datensicherheit und Datenschutz

Wir wissen, wie wichtig der Schutz vertraulicher Daten ist. Deshalb haben wir AI Monitoring mit soliden Sicherheitsfeatures entwickelt, die für die Einhaltung gesetzlicher Vorgaben und den Schutz personenbezogener Daten sorgen. Mit der Drop-Filterfunktion können Sie bestimmte Datentypen (z. B. personenbezogene Angaben) gezielt aus dem Monitoring ausschließen, und unsere vollständige Opt-out-Option erlaubt Ihnen, den Versand von Prompts und Antworten über die Agent-Konfiguration komplett zu unterbinden – so behalten Sie hundertprozentige Kontrolle über die Datenübertragungen.

Drop-Filter lassen sich ganz einfach einrichten: Gehen Sie im Toolset AI Monitoring einfach zum Bereich Drop Filters. Dort können Sie mithilfe von NRQL-Abfragen (New Relic Query Language) Filter für bestimmte Datentypen in den sechs verfügbaren Events erstellen.

Nächste Schritte

Starten Sie noch heute

Mit New Relic AI Monitoring sind Sie für die rasanten Veränderungen gewappnet, die mit der KI-Technologie einhergehen. Dank mühelosem Onboarding und umfassender Transparenz können Sie Ihre KI-Anwendungen im Handumdrehen auf Performance, Qualität und Kosten optimieren. Ganz gleich, ob erfahrene Full-Stack-Entwicklerin oder Branchenneuling: New Relic AI Monitoring liefert Ihnen die nötigen Tools und Einblicke, damit Sie das Maximum aus Ihren KI-Initiativen schöpfen können. Richten Sie sich ein kostenloses New Relic Konto ein und erleben Sie leistungsstarkes KI-Monitoring.

Die in diesem Blog geäußerten Ansichten sind die des Autors und spiegeln nicht unbedingt die Ansichten von New Relic wider. Alle vom Autor angebotenen Lösungen sind umgebungsspezifisch und nicht Teil der kommerziellen Lösungen oder des Supports von New Relic. Bitte besuchen Sie uns exklusiv im Explorers Hub (discuss.newrelic.com) für Fragen und Unterstützung zu diesem Blogbeitrag. Dieser Blog kann Links zu Inhalten auf Websites Dritter enthalten. Durch die Bereitstellung solcher Links übernimmt, garantiert, genehmigt oder billigt New Relic die auf diesen Websites verfügbaren Informationen, Ansichten oder Produkte nicht.