Les applications d'IA générative (GenAI) alimentées par les grands modèles de langage (LLM) présentent un énorme potentiel dans de nombreux secteurs différents. Toutefois, le développement, le déploiement et le monitoring de ces modèles puissants constituent une démarche complexe. C'est pourquoi NVIDIA et New Relic unissent leurs forces pour ouvrir une voie personnalisée pour le développement, le déploiement et le monitoring d'applications d'entreprise alimentées par l'IA en production.

Dans le cadre de NVIDIA AI Enterprise, l'ensemble de microservices cloud natifs de NVIDIA NIM offre des modèles en tant que conteneurs optimisés. Ces conteneurs peuvent être déployés au niveau du cloud, des data centers ou des postes de travail, et permettent la création simple d'applications d'IA générative, telles que les copilotes et les chatbots.

New Relic AI Monitoring s'intègre aisément à NVIDIA NIM et fournit l'observabilité full-stack pour les applications développées sur une large gamme de modèles d'IA pris en charge par NIM, dont Llama 3 de Meta, Mistral Large et Mixtral 8x22B, entre autres. Cette intégration aide les organisations à déployer et monitorer les applications d'IA développées avec NVIDIA NIM en toute confiance, à accélérer la commercialisation et à améliorer le RSI.

Qu'est-ce que NVIDIA NIM ?

NVIDIA NIM est un ensemble de microservices d'inférence qui fournissent des modèles LLM prédéveloppés et optimisés, qui simplifient le déploiement sur toute l'infrastructure accélérée NVIDIA dans le data center et le cloud. Ceci élimine le besoin pour les entreprises de dépenser d'importantes ressources et un temps précieux à optimiser les modèles à exécuter sur différentes infrastructures, en créant des API pour que les développeurs créent des applications, et en maintenant la sécurité et l'assistance pour ces modèles en production. Voici comment NIM s'attaque aux défis de l'IA générative :

- Modèles prédéveloppés et optimisés : NIM offre une bibliothèque de modèles LLM préformés, ainsi vous n'avez pas à fournir l'effort et l'expertise requise pour le développement de modèles. Ces modèles sont spécifiquement optimisés pour les GPU NVIDIA, assurant ainsi des performances efficaces.

- Déploiement simplifié : NIM utilise les microservices conteneurisés, rendant le déploiement très simple. Ces unités préétablies comprennent tout ce dont vous avez besoin pour exécuter le modèle, ce qui permet un déploiement simple et rapide sur différentes plateformes, des environnements cloud aux data centers sur site.

- Sécurité améliorée : pour les applications exigeant une sécurité robuste, l'option de déploiement de modèles NIM autohébergés vous apporte la maîtrise totale de vos données.

Démarrage avec New Relic AI Monitoring pour NVIDIA NIM

New Relic AI Monitoring procure toute la puissance de l'observabilité à l'ensemble du stack d'IA pour les applications développées avec NVIDIA NIM. Vous pouvez ainsi aisément monitorer, déboguer et optimiser vos applications d'IA au niveau des performances, de la qualité et des coûts, tout en assurant la confidentialité des données et la sécurité. Vous trouverez ci-dessous les instructions étape par étape pour lancer le monitoring des applications d'IA développées avec NVIDIA NIM.

Étape 1 : instrumentez votre application d'IA développée avec NVIDIA NIM

Vous devez tout d'abord paramétrer l'instrumentation pour votre application. Voici comment :

- Inscrivez-vous pour obtenir un compte New Relic gratuit ou connectez-vous si vous en avez déjà un.

- Cliquez sur Add Data.

- Dans la barre de recherche, tapez NVIDIA et sélectionnez NVIDIA NIM.

- Choisissez votre langage de programmation (Python, Node.js).

- Suivez le processus d'onboarding fourni par New Relic. Ce processus vous guide dans l'instrumentation de votre application d'IA développée avec NVIDIA NIM. Nous avons nommé notre exemple d'application « local-nim ».

Étape 2 : accédez à AI Monitoring

Lorsque votre application est instrumentée, vous pouvez commencer à utiliser AI Monitoring :

- Naviguez jusqu'à All Capabilities dans votre dashboard New Relic.

- Cliquez sur AI Monitoring.

- Dans la section AI Monitoring, sous All Entities, vous verrez l'exemple d'application « local-nim » que nous avons développée en utilisant NVIDIA NIM.

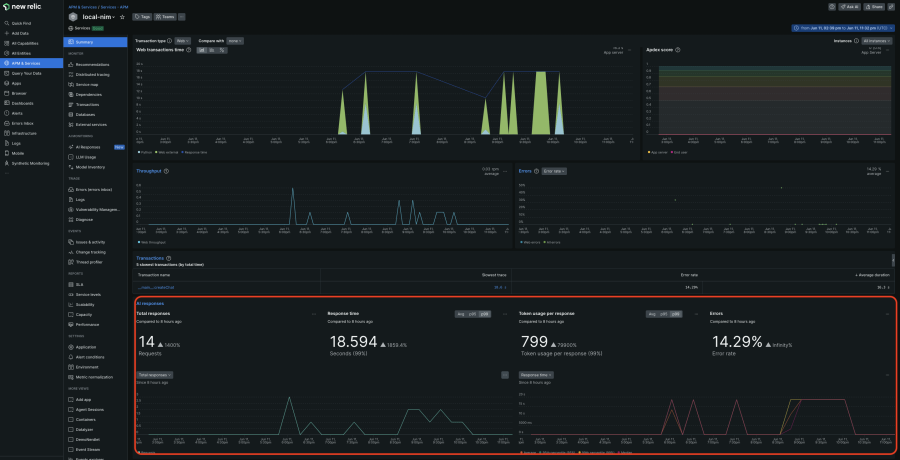

- Cliquez sur l'application « local-nim » pour accéder à la synthèse d'APM 360 avec la vue intégrée du monitoring de l'IA. Cette vue unifiée vous donne des informations instantanées sur les métriques clés de la couche d'IA, telles que le nombre de requêtes, le temps de réponse moyen, l'usage de jetons et les taux de réponse aux erreurs. Ces résultats apparaissent dans le contexte aux côtés de vos signaux dorés de l'APM, informations détaillées sur l'infrastructure et logs. En corrélant toutes ces informations en un seul et même endroit, vous pouvez rapidement identifier la source des problèmes et approfondir l'analyse.

Étape 3 : plongez en profondeur avec le tracing des réponses de l'IA

Pour une analyse plus détaillée, la vue de tracing approfondi est incroyablement utile :

- Dans la synthèse (Summary) d'APM 360, cliquez sur AI Responses sur la gauche et sélectionnez la réponse que vous voulez sonder.

- Vous pouvez voir ici tout le chemin de l'utilisateur initial jusqu'à la réponse finale, y compris les métadonnées comme le décompte de jetons, les informations sur les modèles et les interactions des utilisateurs réels. Ceci vous permet de rapidement trouver la cause profonde du problème.

Étape 4 : explorez l'inventaire des modèles

Model Inventory fournit une vue complète de l'utilisation de modèles sur tous vos services et comptes. Cela vous aide à isoler les problèmes de performances, d'erreurs et de coûts.

- Revenez à la section AI Monitoring.

- Cliquez sur Model Inventory et affichez les métriques de performances, d'erreurs et de coûts modèle par modèle.

Étape 5 : comparez les modèles pour déterminer le choix optimal

Pour choisir le modèle qui correspond le mieux à vos besoins en coûts et performances :

- Cliquez sur Compare Models

- Sélectionnez les modèles, services et plages de temps que vous voulez comparer dans la liste déroulante

Étape 6 : Améliorez la confidentialité et la sécurité

En complétant l'avantage de la sécurité robuste des modèles autohébergés de NVIDIA NIM, New Relic vous permet d'exclure le monitoring des renseignements personnels (PII) dans vos requêtes et réponses d'IA :

- Cliquez sur Drop Filters et créez les filtres pour cibler des types de données spécifiques au sein des six événements offerts.

Accélération de l'IA en production avec New Relic et NVIDIA

New Relic AI Monitoring et NVIDIA NIM offrent une solution probante pour les organisations qui veulent faire progresser rapidement l'IA en production. En tirant parti des modèles prédéveloppés, du déploiement rationalisé et du monitoring complet, les entreprises peuvent mettre plus rapidement en production des applications d'IA générative hautement performantes, ce qui résulte en d'importantes économies et ouvre une voie plus directe vers un meilleur RSI. Cette collaboration marque une étape importante de la démocratisation de l'accès à l'IA et à son potentiel de transformation.

Inscrivez-vous pour obtenir un compte New Relic gratuit et démarrer avec le monitoring de vos applications NVIDIA NIM dès aujourd'hui.

Les opinions exprimées sur ce blog sont celles de l'auteur et ne reflètent pas nécessairement celles de New Relic. Toutes les solutions proposées par l'auteur sont spécifiques à l'environnement et ne font pas partie des solutions commerciales ou du support proposés par New Relic. Veuillez nous rejoindre exclusivement sur l'Explorers Hub (discuss.newrelic.com) pour toute question et assistance concernant cet article de blog. Ce blog peut contenir des liens vers du contenu de sites tiers. En fournissant de tels liens, New Relic n'adopte, ne garantit, n'approuve ou n'approuve pas les informations, vues ou produits disponibles sur ces sites.