Os aplicativos de IA generativa desenvolvidos por grandes modelos de linguagem (large language models, LLMs) têm um imenso potencial em várias indústrias. Entretanto, construir, implantar e monitorar esses modelos poderosos é uma tarefa complexa. Foi aí que a NVIDIA e a New Relic juntaram forças para fornecer um caminho simplificado para o desenvolvimento, implantação e monitoramento de aplicativos empresariais com tecnologia de IA na produção.

O NVIDIA NIM, parte da empresa NVIDIA AI, é um conjunto de microsserviços nativos na nuvem que oferecem modelos como contêineres otimizados. Esses contêineres podem ser implantados em nuvens, data centers ou estações de trabalho, permitindo a fácil criação de aplicativos de IA generativa como copilotos e chatbots.

O AI Monitoring da New Relic se integra perfeitamente com o NVIDIA NIM, oferecendo uma observabilidade full-stack para aplicativos desenvolvidos em uma ampla gama de modelos de IA apoiados pelo NIM, incluindo Llama 3 da Meta, Mistral Large e Mixtral 8x22B, entre outros. Essa integração ajuda as organizações a implantar e monitorar com confiança os aplicativos de IA desenvolvidos com o NVIDIA NIM, acelerar o tempo de entrada ao mercado e aprimorar o ROI.

O que é o NVIDIA NIM?

O NVIDIA NIM é um conjunto de microsserviços de inferência que oferece modelos de LLM otimizados e pré-desenvolvidos que simplificam a implantação na infraestrutura acelerada da NVIDIA no data center e na nuvem. Isso elimina a necessidade das empresas de gastarem tempo e recursos valiosos otimizando modelos para funcionarem em diferentes infraestruturas, criando APIs para desenvolvedores construírem aplicativos e mantendo a segurança e o suporte para esses modelos na produção. Veja aqui como o NIM combate os desafios da IA generativa:

- Modelos otimizados e pré-desenvolvidos: o NIM oferece uma biblioteca de modelos de LLM pré-treinados, economizando a expertise e o esforço necessários para o desenvolvimento dos modelos. Esses modelos são especificamente otimizados para os NVIDIA GPUs, garantindo um desempenho eficiente.

- Implantação simplificada: o NIM utiliza microsserviços em contêineres, facilitando a implantação. Essas unidades pré-empacotadas incluem tudo o que é necessário para que o modelo funcione, permitindo uma implantação rápida e fácil em diversas plataformas, desde ambientes em nuvem a data centers físicos.

- Segurança aprimorada: para aplicativos que requerem uma segurança robusta, a opção de implantação de modelo auto-hospedado do NIM oferece um controle completo dos seus dados.

Começando com o AI Monitoring da New Relic para NVIDIA NIM

O AI Monitoring da New Relic oferece o poder da observabilidade a toda a stack de IA para aplicativos desenvolvidos com o NVIDIA NIM. Isso permite que você monitore facilmente, resolva bugs e otimize seus aplicativos de IA para desempenho, qualidade e custo, enquanto assegura a privacidade e a segurança dos dados. Aqui está um passo a passo das instruções que o ajudarão a iniciar o monitoramento dos aplicativos de IA desenvolvidos com o NVIDIA NIM

Etapa 1: Defina a instrumentação do seu aplicativo de IA desenvolvido com o NVIDIA NIM

Primeiro, você precisa definir a instrumentação para o seu aplicativo. Veja como:

- Obtenha uma conta gratuita na New Relic ou faça o login se você já tiver uma conta.

- Clique em Add Data.

- Na barra de pesquisa, digite NVIDIA e selecione NVIDIA NIM.

- Escolha a linguagem de programação (Python, Node.js) do seu aplicativo.

- Siga o processo de integração guiado fornecido pela New Relic. Esse processo vai orientá-lo sobre a instrumentação do seu aplicativo de IA desenvolvido com o NVIDIA NIM. Chamamos o nosso exemplo de aplicativo de "local-nim".

Etapa 2: Acesse o AI Monitoring

Uma vez que seu aplicativo for instrumentado, você pode começar a usar o AI Monitoring:

- Navegue até All Capabilities no seu dashboard da New Relic.

- Clique em AI Monitoring.

- Na seção AI Monitoring, em All Entities, você verá o exemplo de aplicativo "local-nim" que desenvolvemos usando o NVIDIA NIM.

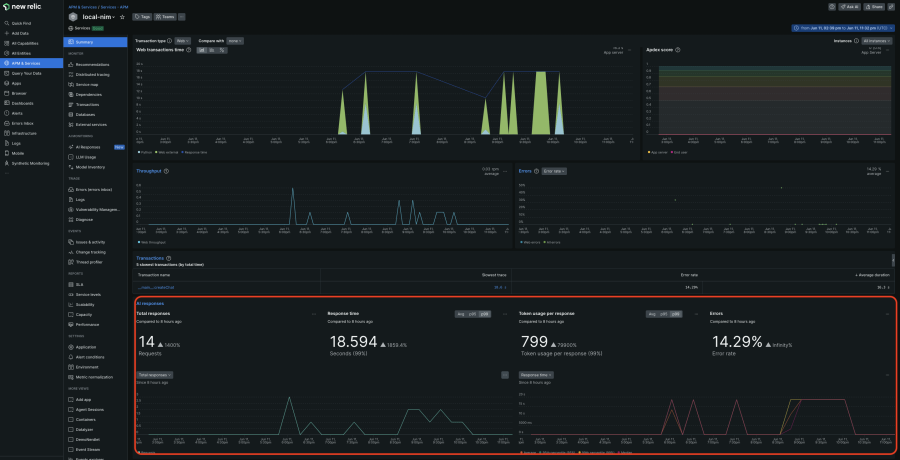

- Clique no aplicativo local-nim para acessar o resumo do APM 360 com a visualização integrada do AI Monitoring. Essa visualização unificada dá a você insights instantâneos das principais métricas das camadas da IA, tais como o número total de pedidos, tempo médio de resposta, uso de token e taxas de erros de resposta. Esses resultados aparecem no contexto, junto com os sinais clássicos de APM, insights de infraestrutura e logs. Ao correlacionar todas essas informações em um só lugar, você pode identificar rapidamente a fonte dos problemas e se aprofundar ainda mais nas análises.

Etapa 3: Mergulhe fundo com o monitoramento de resposta da IA

Para uma análise mais detalhada, a visualização de monitoramento profundo é extremamente útil:

- No resumo do APM 360, clique na navegação AI responses no lado esquerdo e selecione a resposta na qual você quer se aprofundar.

- Aqui, você pode ver todo o caminho, desde a inserção inicial do usuário até a resposta final, incluindo metadados como contagem de token, informações do modelo e interações dos usuários reais. Isso permite que você chegue à raiz do problema rapidamente.

Etapa 4: Explore o inventário de modelos

O inventário de modelos fornece uma visão abrangente do uso dos modelos em todos os seus serviços e contas. Isso ajuda você a isolar o desempenho, os erros e os problemas de custo relacionados aos modelos.

- Volte para a seção AI Monitoring.

- Clique em Model Inventory e visualize o desempenho, os erros e as métricas de custo para cada modelo

Etapa 5: Compare modelos e faça a escolha ideal

Para escolher o modelo que melhor se encaixa nos seus custos e necessidades de desempenho:

- Clique em Compare Models

- Selecione os modelos, o serviço e a faixa de tempo que você quer comparar na lista do menu suspenso

Etapa 6: Melhore a privacidade e a segurança

Para complementar a vantagem robusta de segurança dos modelos auto-hospedados do NVIDIA NIM, a New Relic permite que você exclua o monitoramento de dados sigilosos (PII) em seus pedidos e respostas de IA:

- Clique em Drop Filters e crie filtros voltados para os tipos de dados específicos dentro dos seis eventos oferecidos.

Acelerar a IA na produção com a New Relic e a NVIDIA

O AI Monitoring da New Relic e o NVIDIA NIM oferecem uma solução compacta para organizações que buscam acelerar a IA na produção. Aproveitando-se dos modelos pré-desenvolvidos, da implantação simplificada e do monitoramento abrangente, as empresas podem fornecer aplicativos de IA generativa de alto desempenho mais rapidamente, resultando em uma economia de custos significativa e um caminho mais rápido para ROI. Essa colaboração marca um avanço significativo no acesso democrático à IA e seu potencial transformador.

Obtenha uma conta gratuita na New Relic e comece com o monitoramento dos seus aplicativos NVIDIA NIM hoje mesmo.

As opiniões expressas neste blog são de responsabilidade do autor e não refletem necessariamente as opiniões da New Relic. Todas as soluções oferecidas pelo autor são específicas do ambiente e não fazem parte das soluções comerciais ou do suporte oferecido pela New Relic. Junte-se a nós exclusivamente no Explorers Hub ( discuss.newrelic.com ) para perguntas e suporte relacionados a esta postagem do blog. Este blog pode conter links para conteúdo de sites de terceiros. Ao fornecer esses links, a New Relic não adota, garante, aprova ou endossa as informações, visualizações ou produtos disponíveis em tais sites.