Die KI-Landschaft entwickelt sich ständig weiter und mit jedem Fortschritt geht das Versprechen größerer Effizienz, verbesserter Performance und geringerer Kosten einher. Das neueste Angebot von OpenAI, GPT-4o, wurde als transformativer Sprung nach vorne positioniert, insbesondere für Unternehmen, die zusammengesetzte KI-Systeme nutzen. GPT-4o soll schnellere Antwortzeiten, niedrigere Betriebskosten und erweiterte Funktionen in Bereichen wie der Verarbeitung natürlicher Sprache (NLP) und mehrsprachiger Unterstützung bieten. Allerdings ist die Umstellung auf ein neues Modell eine komplexe Entscheidung, die sorgfältig überlegt werden muss.

Wir bei New Relic prüfen derzeit den möglichen Wechsel von GPT-4 Turbo zu GPT-4o für unseren GenAI-Assistenten New Relic AI. Da wir bereits den Übergang von GPT-4 zu GPT-4 Turbo bewältigt haben, wissen wir, dass die Realität bei der Einführung einer neuen Technologie oft von den anfänglichen Erwartungen abweicht. In diesem Blog möchten wir die Umstellung auf GPT-4o aus der Anwenderperspektive erläutern. Wir werden die praktischen Auswirkungen eines solchen Umstiegs untersuchen, einschließlich Performance-Metriken, Integrationsschwierigkeiten, Kapazitätsaspekte und Kosteneffizienz, basierend auf unseren vorläufigen Tests und Erfahrungen. Unser Ziel ist es, eine ausgewogene Sichtweise zu bieten, die sowohl die potenziellen Vorteile als auch die Herausforderungen berücksichtigt und anderen Unternehmen hilft, fundierte Entscheidungen darüber zu treffen, ob GPT-4o die richtige Wahl für ihre KI-Systeme ist.

Das GPT-4o-Modell verstehen

Um GPT-4o effektiv zu bewerten, ist es wichtig, seine Hauptfeatures und prognostizierten Vorteile zu verstehen. Dieser Abschnitt bietet einen kurzen Überblick über die Möglichkeiten mit GPT-4o.

Analysefunktionen

GPT-4o wurde entwickelt, um die Verarbeitung natürlicher Sprache (NLP) zu verbessern und eine verbesserte Genauigkeit und ein besseres Verständnis bei komplexen Abfragen zu bieten. Wir erwarten, dass es in mehrsprachigen Umgebungen eine bessere Leistung bietet und relevantere Antworten liefert.

Ressourceneffizienz

Eines der Hauptverkaufsargumente von GPT-4o ist seine Ressourceneffizienz. Es verspricht eine hohe Leistung bei gleichzeitig geringerem Verbrauch von Rechenressourcen und kann so zu geringeren Betriebskosten führen. Dieser Aspekt ist besonders wichtig für Unternehmen, die ihre KI-Aktivitäten skalieren möchten, ohne ihre Infrastruktur deutlich zu erhöhen.

Benutzerfreundlichkeit und Integration

GPT-4o soll sich nahtlos in bestehende Workflow und Tools integrieren. Die Verbesserungen sollen es Entwickler:innen einfacher machen, das Modell in ihre Anwendungen zu integrieren und so den für die Integration erforderlichen Zeit- und Arbeitsaufwand zu reduzieren. Wie wir jedoch bei der Performance-Beurteilung sehen werden, kann dies in der Praxis variieren.

Zugänglichkeit und Preise

Ein wesentlicher Vorteil von GPT-4o ist seine Kosteneffizienz. Es ist ungefähr halb so teuer wie seine Vorgänger und stellt daher eine attraktive Option für Unternehmen dar, die ihre Betriebskosten senken möchten. Diese Preisgestaltung kann die Einstiegshürde für erweiterte KI-Funktionen erheblich senken und es mehr Unternehmen ermöglichen, die Leistungsfähigkeit von GPT-4o für ihren Betrieb zu nutzen.

Den Hype bewerten

Obwohl die angekündigten Vorteile von GPT-4o attraktiv sind, ist es wichtig, sie durch praktische Tests kritisch zu beurteilen. Unsere ersten Erfahrungen mit GPT-4o haben gemischte Ergebnisse geliefert, sodass eine intensivere Auseinandersetzung mit bestimmten Aspekten erforderlich ist.

Um GPT-4o umfassend zu evaluieren, haben wir eine Reihe von Experimenten durchgeführt, die sich auf verschiedene Performance- und Integrationsaspekte konzentrierten:

- Latenz- und Throughput-Tests: Wir haben die Reaktionsgeschwindigkeit und Verarbeitungskapazität während der Spitzen- und Nebenzeiten gemessen.

- Qualität der Ergebnisse: Wir haben die Genauigkeit und Relevanz der Antworten bei verschiedenen Aufgaben bewertet.

- Workflow-Integration: Wir haben beurteilt, wie gut sich GPT-4o in unsere vorhandenen Tools und Workflows integrieren lässt.

- Token-Effizienz: Wir haben die Tokennutzung pro Prompt zwischen GPT-4 Turbo und GPT-4o verglichen, um die Kostenauswirkungen zu verstehen.

- Skalierbarkeitstests: Wir haben die Performance bei zunehmender Belastung beobachtet, um die Skalierbarkeit zu bewerten.

- Kostenanalyse: Wir haben die Kostenauswirkungen basierend auf der Tokennutzung und der Betriebseffizienz analysiert.

Performance-Beurteilung

Bei unserer Bewertung von GPT-4o haben wir seine Leistung mit zwei anderen Modellen verglichen: GPT-4 Turbo und GPT-4 Turbo PTU mit Zugriff über Azure OpenAI. Bei New Relic verwenden wir GPT-4 Turbo hauptsächlich über die Option „Provisioned Throughput Unit“ (PTU), die dedizierte Ressourcen und geringere Latenz im Vergleich zum Pay-as-you-go-Modell bietet. Dieser Vergleich soll ein klares Bild davon vermitteln, wie GPT-4o im Hinblick auf Throughput und Ausgabequalität unter verschiedenen Bedingungen abschneidet.

Throughput-Analyse

Throughput, gemessen in Token pro Sekunde, spiegelt die Fähigkeit eines Modells wider, große Datenmengen effizient zu verarbeiten. Der Throughput gibt auch einen Hinweis auf die Latenz, da ein höherer Throughput im Allgemeinen mit einer geringeren Latenz korreliert.

Unsere ersten Tests am 24. Mai zeigten deutliche Leistungsunterschiede bei den drei Modellen:

-

GPT-4 Turbo PTU: Zeigte einen Throughput von etwa 35 Token/Sek. Der hohe Throughput ist ein Hinweis auf die Vorteile der dedizierten Ressourcen, die die PTU bietet, und macht sie für Datenverarbeitungsprozesse mit hohem Volumen geeignet, bei denen eine gleichbleibende Performance entscheidend ist.

-

GPT-4 Turbo: Beim Pay-as-you-go-Modell zeigte GPT-4 Turbo einen Throughput von etwa 15–20 Token/Sek. Obwohl es effizient ist, weist es im Vergleich zum PTU-Modell einige Einschränkungen auf, was wahrscheinlich auf das Konzept der gemeinsam genutzten Ressourcen zurückzuführen ist, das Variabilität mit sich bringt.

-

GPT-4o: Zeigte einen Throughput von etwa 50 Token/Sek., was der Angabe von OpenAI entspricht, dass GPT-4o im Vergleich zu GPT-4 Turbo doppelt so schnell sei. Zwar zeigte GPT-4o Potenzial bei der Datenverarbeitung im großen Maßstab, es wies jedoch auch eine größere Variabilität auf, was darauf schließen lässt, dass die Performance je nach Lastbedingungen schwanken könnte.

Wir haben die Performance dieser Modelle über einen längeren Zeitraum beobachtet, um zu verstehen, wie sie mit unterschiedlichen Belastungen zurechtkommen. Weitere am 11. Juni durchgeführte Tests lieferten zusätzliche Einblicke in die Performance dieser Modelle:

- GPT-4 Turbo PTU: Zeigte eine ziemlich konstante Performance mit Spitzenwerten von etwa 35 Token/Sek. Diese gleichbleibende Leistung bestätigt die Vorteile von PTU für Anwendungen, die eine zuverlässige und schnelle Verarbeitung erfordern.

- GPT-4 Turbo: Ein Throughput von etwa 15–20 Token/Sek. wurde beibehalten, es zeigte sich jedoch ein leichter Rückgang der Spitzendichte, was auf eine weniger vorhersehbare Latenz aufgrund der erhöhten Variabilität hindeutet.

- GPT-4o: Zeigte einen deutlichen Rückgang des Throughput mit einem Spitzenwert von jetzt etwa 20 Token/Sek. Aufgrund unserer Erfahrungen mit der Umstellung von GPT-4 auf GPT-4 Turbo kann man davon ausgehen, dass eine höhere Nachfrage nach GPT-4o-Endpunkten (mit Zugriff über ein Pay-as-you-go-Modell) die Effizienz weiter beeinträchtigen und möglicherweise die Eignung für Anwendungen beeinträchtigen könnte, die einen konstant hohen Throughput und geringe Latenz erfordern.

Qualität der Ergebnisse

Zusätzlich zum Throughput haben wir die Qualität der Ausgaben jedes Modells anhand der Fähigkeit bewertet, genaue und relevante Antworten für verschiedene Aufgaben zu generieren. Diese Bewertung umfasst die Verarbeitung natürlicher Sprache, mehrsprachige Unterstützung, allgemein gleichbleibender Output und Integration in vorhandene Workflows.

Verarbeitung natürlicher Sprache (NLP) und mehrsprachige Unterstützung

- GPT-4 Turbo: Beide Bereitstellungsoptionen von GPT-4 Turbo generieren über diverse Aufgaben hinweg konsistent hochwertige Antworten und funktionieren bei NLP-Anwendungen im Allgemeinen gut.

- GPT-4o: Hervorragend geeignet für das Verstehen und Generieren natürlicher Sprache, was es für KI-Aufgaben für Unterhaltungen äußerst effektiv macht. Der o200k_base-Tokenisierer ist für verschiedene Sprachen optimiert, was die Performance in mehrsprachigen Kontexten verbessert und die Tokennutzung reduziert. Allerdings neigt GPT-4o dazu, längere Antworten zu liefern, und kann häufiger halluzinieren, was bei Anwendungen, die präzise Antworten erfordern, eine Einschränkung darstellen kann.

Genauigkeit und Konsistenz

-

GPT-4 Turbo: Bei Aufgaben, die eine hohe Präzision erfordern, liefert GPT-4 Turbo eine recht gute Leistung und identifiziert bei komplexen Datenextraktionsaufgaben 60–80 % der Daten korrekt. Die Antwortgenauigkeit und das Verhalten bei der Wiederholung derselben Aufgabe können jedoch je nach konkretem Anwendungsfall und Setup variieren.

-

GPT-4o: Zeigt eine vergleichbare Performance wie GPT-4 Turbo. In einigen Bereichen übertrifft GPT-4o die Genauigkeit von GPT-4 Turbo leicht, dies variiert jedoch je nach spezifischer Aufgabe. Zum Beispiel identifiziert GPT-4o bei komplexen Datenextraktionsaufgaben nur 60–80 % der Daten korrekt und weist damit eine vergleichbare Performance auf. Allerdings zeigt GPT-4o eine erhebliche Variabilität in der Antwortkonsistenz, insbesondere wenn die gleiche Aufgabe mehrere Male wiederholt werden soll.

Integrations- und Workflow-Effizienz

- GPT-4 Turbo: Lässt sich im Allgemeinen gut in vorhandene Tools und Workflows integrieren und gewährleistet einen reibungslosen Betrieb und eine gleichbleibende Performance. Es nutzt Integrationen, um umfassende und kontextrelevante Antworten bereitzustellen, und ist somit eine zuverlässige Option für verschiedene Anwendungen. Allerdings mangelt es dem Modell noch immer an Präzision.

- GPT-4o: Obwohl beide Modelle, GPT-4 Turbo und GPT 4o, eine vergleichbare Performance aufweisen, versucht GPT-4o manchmal, Fragen direkt zu beantworten, anstatt integrierte Tools zu nutzen. Dies kann die Workflow-Effizienz in Systemen beeinträchtigen, die auf Tool-Integrationen oder Funktionen für kontextrelevante Antworten angewiesen sind.

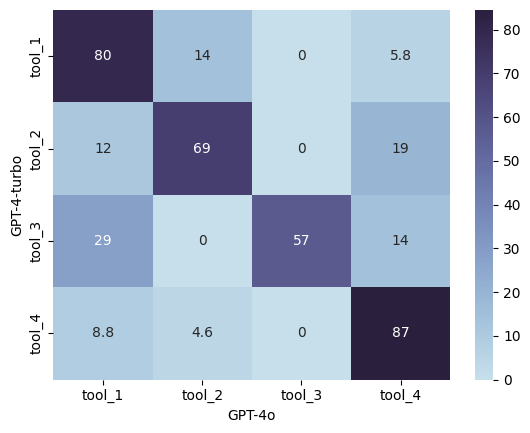

Die folgende Wahrheitsmatrix bietet weitere Einblicke in die unterschiedliche Handhabung von Funktionsaufrufen durch GPT-4 Turbo und GPT-4o und spiegelt ihre Interpretationen von Funktionsbeschreibungen und Benutzerabfragen im Fall von New Relic AI wider.

Die Modelle zeigen eine hohe Übereinstimmung bei bestimmten Tools, wie z. B. bei tool_4 mit 87 % Übereinstimmung, was auf eine konsistente Interpretation dieser Funktion hindeutet. Bei tool_3 sinkt die Übereinstimmung jedoch auf 57 %, was auf eine Variabilität bei der Verarbeitung dieses Tools hinweist. Beide Modelle weisen ähnliche Fehlklassifizierungsmuster auf und verdeutlichen damit nuancierte Unterschiede in ihrem Funktionsaufrufverhalten. Dies deutet darauf hin, dass, obwohl GPT-4o auf dem Papier schneller, besser und weniger teuer ist, das Ersetzen von GPT-4 Turbo durch GPT-4o nicht unbedingt zu einem identischen Verhalten führt. Es gibt immer Nuancen und Modelle können ein unerwartetes Ergebnis liefern.

Tokenisierer-Effizienz

Die Effizienz des Tokenisierers spielt eine entscheidende Rolle für die Performance und Kosteneffizienz der Modelle, insbesondere in mehrsprachigen Kontexten.

| Modell | Tokenisierer | Effizienz |

|---|---|---|

| ModellGPT-4 Turbo | Tokenisierercl100k_base |

Effizienz

|

| ModellGPT-4o | Tokenisierero200k_base |

Effizienz

|

Kosteneffizienz

Das Versprechen von OpenAI, dass mit GPT-4o die Kosten gesenkt würden, ist ein wichtiges Verkaufsargument. GPT-4o ist ungefähr halb so teuer wie seine Vorgänger, wobei der Preis für Input-Token 5 $ pro Million und für Output-Token 15 $ pro Million beträgt. Darüber hinaus ermöglicht GPT-4o im Vergleich zu GPT-4 Turbo einen fünfmal häufigeren Zugriff, was für Anwendungen, die eine kontinuierliche Datenverarbeitung oder Echtzeitanalyse erfordern, äußerst vorteilhaft sein kann.

| Features | GPT-4 Turbo | GPT-4o |

|---|---|---|

| FeaturesEingabetoken | GPT-4 Turbo10 $ pro Million Token | GPT-4o5 $ pro Million Token |

| FeaturesAusgabetoken | GPT-4 Turbo30 $ pro Million Token | GPT-4o15 $ pro Million Token |

| FeaturesRatenlimits | GPT-4 TurboStandard-OpenAI-API-Richtlinien | GPT-4oFünfmal häufigere Zugriffe |

Unsere bisherigen Erfahrungen mit der Umstellung von GPT-4 auf GPT-4 Turbo haben uns jedoch einige wichtige Erkenntnisse vermittelt. Trotz der beworbenen Kostenreduzierung pro 1.000 Token haben wir in bestimmten Anwendungsfällen nicht die erwarteten Einsparungen festgestellt. Diese Diskrepanz wurde vor allem in Anwendungsfällen ohne festgelegtes Ausgabeformat beobachtet, bei denen das Modell die Freiheit hat, so viel Text zu generieren, wie es für richtig hält. Beispielsweise kann bei Retrieval-Augmented Generation(RAG)-Aufgaben, bei denen das Modell eher „gesprächig“ ist, die neue Version des Modells mehr Token pro Antwort generieren. Für dieselbe Frage an New Relic AI („Wie instrumentiere ich meine Python-Anwendung“) kann die neue Version zum Beispiel eine 360 Token umfassende Antwort generieren, während die alte Version eine 300-Token-Antwort generierte. In solchen Fällen erhalten Sie nicht die angekündigte Kostenreduzierung von 50 %.

Ähnlich verhält es sich, wenn GPT-4o zwar geringere Kosten pro Token bietet, die Tokennutzung pro Prompt jedoch aufgrund des Verhaltens des Modells steigen kann (das Modell neigt im Vergleich zu GPT-4 Turbo dazu, „gesprächiger“ zu sein), was möglicherweise einige der Kosteneinsparungen zunichtemacht, wenn die Prompts nicht effektiv optimiert werden. Darüber hinaus können die für GPT-4o erforderlichen Integrations- und Workflow-Anpassungen zusätzliche Entwicklungs- und Betriebskosten verursachen. Angesichts der zuvor besprochenen Integrationsherausforderungen müssen Unternehmen möglicherweise in die Optimierung ihrer Workflows und die Gewährleistung einer nahtlosen Integration in vorhandene Tools investieren. Diese Anpassungen könnten zusätzliche Kosten verursachen, die in die Gesamtkostenanalyse einbezogen werden sollten.

Eine faktenbasierte Entscheidung treffen:

Nachdem Sie die detaillierte Performance- und Kostenmetriken von GPT-4 Turbo und GPT-4o verstanden haben, müssen Sie eine faktenbasierte Entscheidung treffen, die Ihre spezifischen Anforderungen und Ziele berücksichtigt. Dazu gehört eine umfassende Gesamtbewertung der Geschäftsanforderungen, Kostenauswirkungen und Leistungsvorgaben. Folgende Schlüsselfaktoren sollten Sie berücksichtigen:

- Throughput- und Latenzanforderungen: Wenn Ihre Anwendung einen hohen Throughput und eine geringe Latenz erfordert, können die kürzeren Antwortzeiten und höheren Ratenlimits von GPT-4o von Vorteil sein. Dies ist besonders wichtig für Echtzeit-Anwendungen wie Chatbots und virtuelle Assistenten. Es ist jedoch wichtig, die Performance von GPT-4o im Laufe der Zeit zu beobachten. Unsere Tests zeigen, dass die Performance von GPT-4o bei zunehmender Nutzung nachlassen kann, was seine Zuverlässigkeit bei langfristigen Projekten beeinträchtigen könnte. Um eine gleichbleibende Performance zu erzielen, müssen Unternehmen eventuell irgendwann eine Umstellung auf GPT-4o PTU in Betracht ziehen, da dies eine stabilere und zuverlässigere Performance bieten könnte.

- Qualität der Ergebnisse: Obwohl beide Modelle qualitativ hochwertige Ergebnisse liefern, sollten Sie berücksichtigen, wie gleichbleibend die Antworten sind. GPT-4 Turbo bietet möglicherweise eine vorhersehbarere Performance, die für Anwendungen von entscheidender Bedeutung ist, bei denen eine gleichbleibende Qualität wichtig ist.

- Integration in Tools: Wenn Ihr Workflow stark auf integrierte Tools und kontextreiche Antworten angewiesen ist, bewerten Sie, wie die einzelnen Modelle mit diesen Integrationen umgehen. Die Fähigkeit von GPT-4 Turbo, vorhandene Tools zu nutzen, bietet im Vergleich zu GPT-4o möglicherweise eine reibungslosere Workflow-Effizienz.

- Kosten: Vergleichen Sie die Kosten pro Million Token für Eingabe und Ausgabe. GPT-4o ist weniger kostspielig, aber stellen Sie sicher, dass ein potenzieller Anstieg der Tokennutzung pro Prompt diese Einsparungen nicht aufhebt. Bedenken Sie außerdem die zusätzlichen Kosten, die mit Integrations- und Workflow-Anpassungen verbunden sind. Die Umstellung auf GPT-4o kann Änderungen an bestehenden Prozessen erfordern, die Entwicklungs- und Betriebskosten verursachen können.

- Token-Effizienz: Berücksichtigen Sie die Komplexität und Sprachenvielfalt Ihrer Inhalte. Der o200k_base-Tokenisierer von GPT-4o ist bei mehrsprachigen Aufgaben effizienter und reduziert potenziell die Tokennutzung und die Kosten für nicht-englische Inhalte.

- Ratenlimits und Nutzung: Die höheren Ratenlimits von GPT-4o ermöglichen häufigere Interaktionen und machen es für Anwendungen mit hohem Interaktionsvolumen geeignet. Dadurch kann eine reibungslosere Performance bei hoher Nachfrage gewährleistet werden.

- Skalierbarkeit: Berücksichtigen Sie die langfristige Skalierbarkeit Ihrer Anwendung. Die Kosten- und Performance-Verbesserungen von GPT-4o bieten möglicherweise eine bessere Skalierbarkeit, aber beurteilen Sie, wie diese Vorteile mit Ihren Wachstumsprognosen und der Ressourcenverfügbarkeit übereinstimmen.

Fazit

Die Entscheidung zwischen GPT-4 Turbo und GPT-4o erfordert eine sorgfältige Bewertung Ihrer spezifischen Anforderungen und Ziele. GPT-4o bietet Kostenvorteile und höhere Effizienz in mehrsprachigen Kontexten, kann jedoch mit einer höheren Tokennutzung und potenziellen Integrationsherausforderungen verbunden sein. Aufgrund möglicher Verschlechterungen ist das Monitoring der Performance im Zeitverlauf von entscheidender Bedeutung. Für eine stabile, konstante Performance bleibt GPT-4 Turbo eine zuverlässige Option. Anhand dieser Bewertungskriterien können Sie das Modell auswählen, das Ihren Betriebsanforderungen am besten entspricht und sowohl optimale Performance als auch Kosteneffizienz gewährleistet.

Nächste Schritte

Behalten Sie mit New Relic die Nase vorn bei KI-Innovationen. Melden Sie sich noch heute kostenlos an und optimieren Sie Ihre KI-Unternehmenslösungen mit umfassenden KI-Monitoring-Tools von New Relic.

Weitere Infos zur Leistung und Integration von KI finden Sie in diesen hilfreichen Ressourcen von New Relic:

- GenAI-Performance unter der Lupe: Wenn Ihre Daten „alles Mögliche“ sind

- Von der Idee bis zum Launch: Verwenden Sie die Einblicke von New Relic, um Ihren ersten GenAI-Chatbot zu entwickeln und zu überwachen

Die in diesem Blog geäußerten Ansichten sind die des Autors und spiegeln nicht unbedingt die Ansichten von New Relic wider. Alle vom Autor angebotenen Lösungen sind umgebungsspezifisch und nicht Teil der kommerziellen Lösungen oder des Supports von New Relic. Bitte besuchen Sie uns exklusiv im Explorers Hub (discuss.newrelic.com) für Fragen und Unterstützung zu diesem Blogbeitrag. Dieser Blog kann Links zu Inhalten auf Websites Dritter enthalten. Durch die Bereitstellung solcher Links übernimmt, garantiert, genehmigt oder billigt New Relic die auf diesen Websites verfügbaren Informationen, Ansichten oder Produkte nicht.