Le paysage de l’IA évolue constamment et chaque avancée s’accompagne de la promesse d’une plus grande efficacité, de performances améliorées et d’une réduction des coûts. La dernière offre d'OpenAI, GPT-4o, a été décrite comme un bond en avant vers la transformation, notamment pour les entreprises utilisant des systèmes d'IA composés. GPT-4o offrirait des temps de réponse plus rapides, des coûts opérationnels réduits et des capacités améliorées dans des domaines tels que le traitement du langage naturel et la prise en charge multilingue. Cependant, la transition vers un nouveau modèle est une décision complexe qui nécessite un examen attentif.

Chez New Relic, nous évaluons actuellement le passage potentiel de GPT-4 Turbo à GPT-4o pour notre assistant GenAI, New Relic AI. Ayant déjà traversé la transition de GPT-4 vers GPT-4 Turbo, nous comprenons que la réalité de l'adoption de nouvelles technologies diffère souvent des attentes initiales. Dans ce blog, nous visons à fournir le point de vue d'un professionnel sur la transition vers GPT-4o. Nous nous basons sur nos tests et expériences préliminaires pour explorer les implications pratiques d'une telle démarche, notamment au niveau des métriques de performances, des défis d'intégration, des soucis de capacité et de la rentabilité. Notre objectif est d'offrir une vision équilibrée qui aborde à la fois les avantages potentiels et les défis afin d'aider d'autres entreprises à décider en toute connaissance de cause si GPT-4o est le bon choix pour leurs systèmes d'IA.

Comprendre le modèle GPT-4o

Pour évaluer efficacement GPT-4o, il est important de comprendre ses principales fonctionnalités et les avantages prévus. Cette section fournit un aperçu de ce que propose GPT-4o.

Capacités d'analyse

GPT-4o a été conçu pour améliorer les tâches de traitement du langage naturel et offre une précision et une compréhension améliorées des requêtes complexes. La solution devrait être plus performante dans les environnements multilingues et fournir des réponses plus pertinentes.

Efficacité des ressources

L'un des principaux arguments de vente de GPT-4o est l'efficacité en ce qui concerne les ressources. Il promet d'offrir de hautes performances tout en utilisant moins de ressources de calcul, ce qui pourrait entraîner une réduction des coûts opérationnels. Cet aspect est particulièrement important pour les entreprises qui cherchent à faire évoluer leurs opérations d’IA sans augmenter significativement leurs coûts d'infrastructure.

Convivialité et intégration

GPT-4o prétend s'intégrer de manière transparente aux workflows et aux outils existants. Ses améliorations visent à permettre aux développeurs d'incorporer plus facilement le modèle dans leurs applications, réduisant ainsi le temps et les efforts nécessaires à l'intégration. Cependant, comme nous le verrons lors de l'évaluation des performances, l'expérience pratique peut varier.

Accessibilité et tarifs

Un avantage important de GPT-4o est sa rentabilité. Il est environ deux fois moins cher que ses prédécesseurs, ce qui en fait une option intéressante pour les entreprises visant à réduire leurs coûts opérationnels. Cette tarification peut réduire considérablement les obstacles à l'accès aux capacités avancées de l’IA et permettre ainsi à davantage d’entreprises de tirer parti de la puissance de GPT-4o dans leurs opérations.

Évaluation de l'engouement

Bien que les avantages commercialisés de GPT-4o soient attrayants, il est important de les évaluer de manière critique au moyen de tests pratiques. Nos premières expériences avec GPT-4o ont donné des résultats mitigés, justifiant une analyse plus approfondie d'aspects spécifiques.

Pour évaluer GPT-4o dans sa globalité, nous avons mené une série de tests axés sur divers aspects des performances et de l'intégration :

- Tests de latence et de débit : nous avons mesuré la vitesse de réponse et les capacités de traitement pendant les heures de pointe et en dehors de celle-ci.

- Qualité des résultats : nous avons évalué l'exactitude et la pertinence des réponses pour différentes tâches.

- Intégration du workflow : nous avons estimé dans quelle mesure GPT-4o s'intègre à nos outils et workflows existants.

- Efficacité des tokens : nous avons comparé l'utilisation des tokens par prompt entre GPT-4o Turbo et GPT-4o pour comprendre les implications en termes de coûts.

- Tests d'évolutivité : nous avons monitoré les performances sous des charges croissantes pour jauger l'évolutivité.

- Analyse des coûts : nous avons analysé les implications en termes de coûts en fonction de l'utilisation des tokens et de l'efficacité opérationnelle.

Évaluation des performances

Dans notre évaluation de GPT-4o, nous avons comparé ses performances à celles de deux autres modèles : GPT-4 Turbo et GPT-4 Turbo PTU, accessibles via Azure OpenAI. Chez New Relic, nous utilisons principalement GPT-4 Turbo — par le biais de l'option d'unité de débit provisionnée (PTU) — qui offre des ressources dédiées et une latence inférieure par rapport au modèle de paiement à l'utilisation. La comparaison vise à fournir une image claire des performances de GPT-4o en termes de débit et de qualité de sortie dans différentes conditions.

Analyse du débit

Le débit, mesuré en tokens par seconde, reflète la capacité d'un modèle à gérer efficacement de gros volumes de données. Cela donne également une indication de la latence, car un débit plus élevé est généralement corrélé à une latence plus faible.

Nos premiers tests du 24 mai ont révélé des particularités distinctes au niveau des performances entre les trois modèles :

-

GPT-4 Turbo PTU : affiche un débit d'environ 35 tokens/s. Le débit élevé est révélateur des avantages des ressources dédiées fournies par le PTU, ce qui le rend compatible avec des tâches de traitement des données de haut volume où il est essentiel d'avoir des performances homogènes.

-

GPT-4 Turbo : fonctionnant selon le modèle de paiement à l'utilisation, GPT-4 Turbo a affiché un débit maximal d'environ 15 à 20 tokens/s. Bien qu'efficace, il présentait certaines limites par rapport au modèle PTU, probablement en raison du modèle de ressources partagées qui présente une certaine variabilité.

-

GPT-4o : a démontré une capacité de débit d'environ 50 tokens/s, conformément à l'affirmation d'OpenAI selon laquelle GPT-4o est 2 fois plus rapide que GPT-4 Turbo. Bien que GPT-4o ait prouvé son potentiel dans le traitement des données à grande échelle, il a également présenté une plus grande variabilité, ce qui suggère que les performances pourraient fluctuer en fonction des conditions de charge.

Nous avons continué à monitorer les performances de ces modèles au fil du temps pour comprendre comment ils font face à des charges variables. D'autres tests effectués le 11 juin ont fourni des informations détaillées sur l'évolution des performances de ces modèles :

- GPT-4 Turbo PTU : a montré des performances plutôt constantes avec un pic d'environ 35 tokens/s. Cette cohérence réaffirme les avantages du PTU pour les applications nécessitant un traitement fiable et rapide.

- GPT-4 Turbo : maintien d'un débit maximal d'environ 15 à 20 tokens/s, mais a montré une légère diminution de la densité maximale, indiquant une latence moins prévisible en raison d'une variabilité accrue.

- GPT-4o : a montré une diminution significative du débit avec un pic désormais d'environ 20 tokens/s. D'après notre expérience de la transition de GPT-4 vers GPT-4 Turbo, il est raisonnable de penser qu'une demande plus élevée de points de terminaison GPT-4o (accessibles via le modèle de paiement à l'utilisation) pourrait miner davantage son efficacité et éventuellement impacter son adéquation aux applications qui nécessitent un débit élevé et une faible latence.

Qualité des résultats

Outre le débit, nous avons évalué la qualité des résultats de chaque modèle, en nous concentrant sur leur capacité à générer des réponses exactes et pertinentes pour diverses tâches. Cette évaluation comprend le traitement du langage naturel, la prise en charge multilingue, la cohérence globale et l'intégration avec les workflows existants.

Traitement du langage naturel et support multilingue

- GPT-4 Turbo : les deux options de provisionnement de GPT-4 Turbo génèrent systématiquement des réponses de qualité pour diverses tâches et fonctionnent généralement bien dans les applications de traitement du langage naturel.

- GPT-4o : excelle dans la compréhension et la génération du langage naturel, ce qui le rend très efficace pour les tâches d'IA conversationnelle. Le tokenizer o200k_base est optimisé pour différentes langues, améliorant ainsi les performances dans des contextes multilingues et réduisant l'utilisation des tokens. Cependant, GPT-4o a tendance à fournir des réponses plus longues et peut avoir des hallucinations plus fréquentes, ce qui peut constituer une limitation dans les applications nécessitant des réponses concises.

Précision et cohérence

-

GPT-4 Turbo : dans les tâches nécessitant une haute précision, GPT-4 Turbo fonctionne relativement bien et identifie correctement 60 à 80 % des données dans les tâches d'extraction de données complexes. Toutefois, lorsque la même tâche est répétée, la précision des réponses et le comportement ne sont pas toujours cohérents en fonction du cas d'utilisation spécifique et du paramétrage.

-

GPT-4o : affiche des performances comparables à celles du GPT-4 Turbo. Dans certains domaines, le GPT-4o surpasse légèrement le GPT-4 Turbo en termes de précision, bien que cela varie en fonction de la tâche. Par exemple, dans les tâches d'extraction de données complexes, GPT-4o identifie correctement seulement 60 à 80 % des données, ce qui correspond à des performances comparables. GPT-4o montre cependant une variabilité significative dans la cohérence des réponses, en particulier lorsqu'on lui demande de répéter plusieurs fois la même tâche.

Intégrations et efficacité du workflow

- GPT- 4 Turbo : s'intègre généralement bien aux outils et workflows existants, ce qui garantit des opérations fluides et des performances constantes. Il exploite les intégrations pour fournir des réponses complètes et contextuellement pertinentes, ce qui en fait une option fiable pour diverses applications. Mais le modèle manque encore de précision.

- GPT-4o : bien que les deux modèles, GPT-4 Turbo et GPT 4o, affichent des performances comparables, GPT-4o tente parfois de répondre directement aux questions plutôt que d'utiliser les outils intégrés. Cela peut perturber l'efficacité du workflow dans les systèmes qui reposent sur des intégrations d'outils ou des fonctions pour des réponses adaptées au contexte.

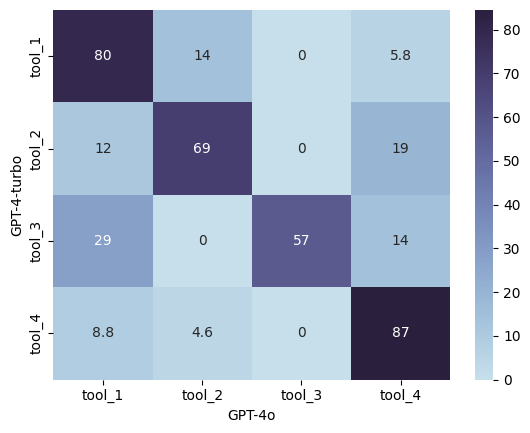

La matrice de confusion ci-dessous fournit des informations détaillées sur la manière dont GPT-4 Turbo et GPT-4o gèrent les appels de fonction différemment, ce qui reflète leur interprétation des descriptions de fonctions et des requêtes de l'utilisateur dans le cas de New Relic AI.

Les modèles montrent un accord élevé sur certains outils, tels que tool_4 avec un accord de 87 %, indiquant une interprétation cohérente de cette fonction. Cependant, l'accord tombe à 57 % pour tool_3, ce qui montre une variabilité dans le traitement de cet outil particulier. Les deux modèles présentent des schémas d’erreur de classification similaires et mettent en évidence des différences nuancées dans leur comportement d’appel de fonction. Cela suggère que même si GPT-4o est en théorie plus rapide, meilleur et moins cher, remplacer GPT-4 Turbo par GPT-4o ne produira pas nécessairement un comportement identique. Il y a toujours des nuances et les modèles peuvent donner un résultat inattendu.

Efficacité du tokenizer

L'efficacité du tokenizer joue un rôle essentiel dans les performances globales et la rentabilité des modèles, en particulier dans des contextes multilingues.

| Modèle | Tokenizer | Efficacité |

|---|---|---|

| ModèleGPT-4 Turbo | Tokenizercl100k_base |

Efficacité

|

| ModèleGPT-4o | Tokenizero200k_base |

Efficacité

|

Rapport coût-efficacité

L'affirmation d'OpenAI concernant la réduction des coûts avec GPT-4o est un argument de vente important. GPT-4o est environ deux fois moins cher que ses prédécesseurs, avec des tokens d'entrée au prix de 5 USD par million et des tokens de sortie à 15 USD par million. De plus, GPT-4o permet un accès cinq fois plus fréquent que GPT-4 Turbo, ce qui peut être très bénéfique pour application nécessitant un traitement des données continu ou des analyses en temps réel.

| Fonctionnalité | GPT-4 Turbo | GPT-4o |

|---|---|---|

| FonctionnalitéTokens d'entrée | GPT-4 Turbo10 USD par million de tokens | GPT-4o5 USD par million de tokens |

| FonctionnalitéTokens de sortie | GPT-4 Turbo30 USD par million de tokens | GPT-4o15 USD par million de tokens |

| FonctionnalitéLimites des tarifs | GPT-4 TurboPolitiques standard de l'API OpenAI | GPT-4oAccès cinq fois plus fréquent |

Notre expérience précédente avec la transition de GPT-4 vers GPT-4 Turbo a toutefois mis en évidence quelques enseignements importants. Malgré la réduction annoncée des coûts pour 1 000 tokens, nous n’avons pas constaté les économies escomptées dans certains cas d’utilisation. Cet écart a été principalement observé dans les cas d'utilisation sans format de sortie spécifié, où le modèle peut générer autant de texte qu'il estime approprié. Par exemple, dans les tâches de génération augmentée de récupération (RAG) où le modèle a tendance à être plus « bavard », la nouvelle version du modèle peut générer plus de tokens par réponse. Pour la même question posée à New Relic AI, Comment instrumenter mon application python, la nouvelle version peut générer une réponse à 360 tokens, tandis que l'ancienne générait une réponse à 300 tokens, par exemple. Dans de tels cas, vous n’obtiendrez pas la réduction de coût de 50 % annoncée.

De même, bien que GPT-4o offre des coûts par token inférieurs, le nombre total de tokens utilisés par prompt peut augmenter en raison du comportement du modèle (le modèle a tendance à être plus « plus bavard » que GPT-4 Turbo), ce qui peut contrebalancer une partie des économies de coûts si les prompts ne sont pas optimisés efficacement. De plus, les ajustements d'intégration et de workflows requis pour GPT-4o peuvent nécessiter des coûts de développement et d'exploitation supplémentaires. Compte tenu des défis d'intégration évoqués précédemment, les entreprises devront peut-être investir dans l'optimisation de leur workflow et garantir une intégration transparente avec les outils existants. Ces ajustements pourraient entraîner des coûts supplémentaires, qui devraient être pris en compte dans l’analyse globale du rapport coût-efficacité.

Une prise de décision éclairée :

Après avoir compris la métrique détaillée des performances et des coûts de GPT-4 Turbo et GPT-4o, il est vital de prendre une décision éclairée qui correspond à vos besoins et objectifs spécifiques. Cela implique une évaluation complète de vos besoins commerciaux, des implications en termes de coûts et de performances. Voici les facteurs clés à considérer :

- Besoins en matière de débit et de latence : si votre application nécessite un débit élevé et une faible latence, les temps de réponse plus rapides et les limites de débit plus élevées de GPT-4o peuvent être bénéfiques. Ceci est particulièrement important pour les applications en temps réel comme les chatbots et les assistants virtuels. Cependant, il est important de monitorer les performances de GPT-4o au fil du temps. Nos tests indiquent que les performances de GPT-4o peuvent se dégrader avec une utilisation accrue, ce qui pourrait avoir un impact sur sa fiabilité pour les projets à long terme. Pour des performances constantes, les entreprises pourraient finalement devoir envisager de passer au PTU GPT-4o, qui peut leur offrir des performances plus stables et plus fiables.

- Qualité des résultats : même si les deux modèles fournissent des résultats de haute qualité, tenez compte de la l'uniformité des réponses. GPT-4 Turbo peut offrir des performances plus prévisibles, ce qui est essentiel pour les applications où une qualité uniforme est essentielle.

- Intégration avec des outils : si votre workflow dépend fortement des outils intégrés et des réponses riches en contexte, évaluez la manière dont chaque modèle gère ces intégrations. La capacité de GPT-4 Turbo à exploiter les outils existants pourrait offrir une efficacité de workflow plus fluide par rapport à GPT-4o.

- Coût : comparez le coût par million de tokens pour l'entrée et la sortie. GPT-4o est moins cher, mais assurez-vous que toute augmentation potentielle de l'utilisation des tokens par prompt ne contrebalance pas ces économies. De plus, soyez conscient des coûts supplémentaires associés à l'intégration et aux ajustements du workflow. La transition vers GPT-4o peut nécessiter des modifications des processus existants, ce qui pourrait entraîner des dépenses de développement et d'exploitation.

- Efficacité des tokens : tenez compte de la complexité et de la diversité linguistique de votre contenu. Le tokenizer o200k_base de GPT-4o est plus efficace pour les tâches multilingues, ce qui peut éventuellement réduire l'utilisation de tokens et le coût du contenu non anglais.

- Limites de débit et utilisation : les limites de débit plus élevées de GPT-4o peuvent prendre en charge des interactions plus fréquentes, ce qui le rend adapté aux applications avec des volumes d'interactions élevés. Cela peut garantir des performances plus fluides en cas de forte demande.

- Évolutivité : tenez compte de l'évolutivité à long terme de votre application. Les améliorations en matière de rentabilité et de performances de GPT-4o peuvent offrir une plus grande évolutivité, mais évaluez comment ces avantages s'alignent sur vos projections de croissance et la disponibilité des ressources.

Conclusion

Le choix entre GPT-4 Turbo et GPT-4o nécessite une évaluation minutieuse de vos besoins et objectifs spécifiques. GPT-4o offre des avantages en termes de coûts et une efficacité supérieure dans des contextes multilingues, mais peut impliquer une utilisation des tokens plus élevée et des défis d'intégration potentiels. Le monitoring de ses performances dans le temps est crucial en raison d’une éventuelle dégradation. Pour des performances stables et uniformes, GPT-4 Turbo reste une option fiable. En évaluant ces facteurs, vous pouvez sélectionner le modèle qui correspond le mieux à vos besoins opérationnels et garantit à la fois des performances optimales et une rentabilité optimale.

Étapes suivantes

Gardez une longueur d’avance avec l'innovation en IA grâce à New Relic. Inscrivez-vous gratuitement dès aujourd'hui et optimisez les solutions d'IA de votre entreprise avec les outils complets de monitoring de l'IA de New Relic.

Pour plus d'informations détaillées sur les performances et l'intégration de l'IA, explorez ces ressources essentielles de New Relic :

- Évaluation des performances de l'IA générative : quand vos données vous apportent « les réponses dont vous avez besoin »

- De l'idéation au lancement : utilisez les informations précieuses de New Relic pour développer et monitorer votre premier chatbot d'IA générative

Les opinions exprimées sur ce blog sont celles de l'auteur et ne reflètent pas nécessairement celles de New Relic. Toutes les solutions proposées par l'auteur sont spécifiques à l'environnement et ne font pas partie des solutions commerciales ou du support proposés par New Relic. Veuillez nous rejoindre exclusivement sur l'Explorers Hub (discuss.newrelic.com) pour toute question et assistance concernant cet article de blog. Ce blog peut contenir des liens vers du contenu de sites tiers. En fournissant de tels liens, New Relic n'adopte, ne garantit, n'approuve ou n'approuve pas les informations, vues ou produits disponibles sur ces sites.