Le paysage de l'IA évolue rapidement. De nouveaux modèles d'IA puissants comme Sora, Mistral Next et Gemini 1.5 Pro repoussent les limites du possible. Les entreprises du monde entier sont désireuses d'utiliser ces avancées et de créer des expériences novatrices pour leurs clients.

Chez New Relic, nous comprenons l'immense potentiel de l'IA générative et c'est pourquoi nous avons développé New Relic AI — une solution d'IA générative conçue pour démocratiser l'observabilité. Notre vaste expérience dans le développement de New Relic AI nous a apporté une profonde compréhension des difficultés inhérentes à cet environnement et le besoin crucial d'avoir des solutions de monitoring de l'IA qui soient robustes. C'est pourquoi, nous avons lancé New Relic AI Monitoring — la première solution de monitoring des performances des applications (APM) pour l'IA qui fournit une visibilité inégalée sur tout le stack d'applications d'IA.

Mais la solution New Relic AI Monitoring n'est pas seulement faite pour nous, elle l'est pour tout le monde ! Nous voulons donner aux organisations de toute taille la capacité de suivre la voie de l'IA en toute confiance. C'est pourquoi nous sommes ravis d'annoncer la disponibilité pour tous de New Relic AI Monitoring. Ce nouveau module vient s'ajouter au plus de 30 capacités de la plateforme New Relic et vous permet de monitorer, gérer et optimiser les performances, la qualité et le coût de vos applications d'IA.

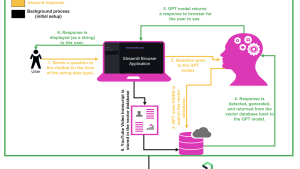

Dans ce billet de blog, nous nous servirons d'un simple service de chat développé avec les grands modèles de langage (LLM) d'OpenAI et LangChain pour vous montrer la puissance de New Relic AI Monitoring. Nous explorerons ses fonctionnalités et nous vous guiderons dans son utilisation pour déboguer les erreurs au niveau de la réponse de votre application d'IA.

Instrumentation et onboarding sans effort

Avec les capacités d'instrumentation automatisées de New Relic, l'intégration du monitoring de l'IA dans vos workflows est simple et intuitive. Que vous utilisiez des frameworks d'IA populaires comme OpenAI ou Amazon Bedrock, nos agents fournissent une instrumentation sans effort dans Python, Node.js, Ruby, Go et .NET. Grâce à l'installation guidée, vous pouvez paramétrer l'instrumentation pour le monitoring de votre application de chat en quelques clics seulement, ce qui garantit que vous êtes bien équipé pour monitorer vos applications d'IA dès le départ.

Prenons en exemple le simple service de chat. Voici comment vous pouvez vous lancer :

- Dans New Relic, naviguez jusqu'à Add Data (Ajouter des données), puis sélectionnez AI Monitoring.

- Sous AI Monitoring, choisissez le framework que vous voulez instrumenter, OpenAI Observability, par exemple.

- Sélectionnez l'agent d'instrumentation — Python dans ce cas — puis suivez les instructions détaillées pour terminer l'instrumentation.

Obtenez des informations instantanées sur l'utilisation des modèles

La gestion et l'optimisation des modèles d'IA peuvent s'avérer complexes, mais Model Inventory simplifie le processus en offrant une vue unifiée et uniformisée complète de l'utilisation de vos modèles. Grâce à la visibilité intégrale sur les métriques clés sur tous vos modèles, il devient facile d'isoler et de diagnostiquer les problèmes associés aux performances, erreurs ou coûts.

Voici comment vous pouvez utiliser l'inventaire des modèles d'IA :

- Depuis New Relic, naviguez jusqu'à AI Monitoring.

- Dans la section Capability, sélectionnez Model Inventory.

- L'onglet Overview fournit une synthèse de tous les temps de réponse, requêtes, utilisations des jetons, exécutions complètes et taux d'erreur pour tous les services et comptes. Cliquez sur n'importe quelle entrée dans le tableau Completion pour accéder à la vue sur le tracing approfondi et voir tout le flux depuis la requête jusqu'à la réponse.

- Cliquez sur l'onglet Errors pour voir les erreurs sur tous les modèles. Vous pouvez facilement isoler les erreurs et les modèles les plus courants avec les taux d'erreur les plus élevés, ce qui facilite l'analyse des causes profondes et une résolution plus facile.

- Cliquez ensuite sur l'onglet Performance pour afficher le nombre total de requêtes et le temps de réponse par modèle. Ceci vous permet de rapidement identifier et optimiser les modèles sous-performants.

- Cliquez sur l'onglet Cost pour afficher l'utilisation des jetons par modèle, ainsi que l'utilisation des jetons de prompts et d'exécutions complètes par modèle, ce qui vous aide à identifier les économies possibles.

- Utilisez les filtres de données pour affiner vos analyses par service, requête ou réponse. Ceci vous permet d'obtenir des informations plus approfondies et de personnaliser vos analyses en fonction de vos besoins spécifiques, améliorant ainsi votre capacité à gérer et optimiser vos modèles d'IA efficacement.

En utilisant Model Inventory, vous pouvez garantir que vos modèles d'IA sont optimalement performants, stables et rentables, et ainsi avoir une base solide pour toutes vos initiatives boostées par l'IA.

Visibilité full-stack pour les applications d'IA

Une fois que votre application d'IA est instrumentée, New Relic AI Monitoring fournit une visibilité inégalée sur ses performances et son comportement. New Relic AI Monitoring va au-delà du monitoring des performances des applications (APM) classiques en s'intégrant en toute transparence à APM 360. Cette combinaison puissante fournit une vue unifiée et uniformisée de votre écosystème d'IA, ce qui vous donne non seulement les métriques de l'APM standard dont vous avez l'habitude (temps de réponse, débit, taux d’erreur), mais aussi les métriques spécifiques à l'IA — comme le nombre total de demandes, le temps de réponse moyen et l'utilisation des jetons — qui sont toutes essentielles à l'optimisation de votre application d'IA. Vous pouvez ainsi réaliser le monitoring de tout votre environnement d'IA efficacement et dans une seule et même interface.

Voyons cela à l'œuvre pour le service de chat.

- Depuis New Relic, naviguez jusqu'à AI Monitoring.

- Cliquez sur AI Entity, puis sélectionnez votre service de chat.

- La vue de synthèse affiche les métriques de l'application et de l'IA côte à côte.

Sous le widget AI Response de la vue de synthèse, vous pouvez voir que le service de chat a traité 2 830 réponses au total avec un temps de réponse moyen de 7,1 secondes et une utilisation moyenne de 858 jetons par réponse.

Identifiez rapidement les valeurs hors norme dans les réponses de l'IA

La compréhension et l'analyse des réponses de l'IA sont très simples grâce à New Relic AI Monitoring. Avec la vue consolidée des réponses de l'IA, vous pouvez rapidement identifier les valeurs hors norme et les tendances dans les réponses des LLM, ce qui vous permet d'affiner votre application pour obtenir des performances, une qualité, et un coût optimums.

Nous pouvons analyser ici le feedback et le ressenti pour chaque réponse de l'IA, et également filtrer en fonction de divers critères, tels que les demandes, les réponses, les erreurs, etc.

Vous pouvez accéder à la vue AI Response de deux façons :

- À partir de la synthèse du service : cliquez sur le widget AI Response pour obtenir une vue focalisée.

- Vue globale : pour une vue consolidée sur toutes les entités, cliquez sur le menu de navigation AI Response principal.

Pour le service de chat, cliquez sur le widget AI Response dans la vue de synthèse. Dans la page de réponse de l'IA, filtrez en fonction des erreurs et observez toutes les réponses de l'IA qui présentent une erreur pour le service de chat.

En cliquant sur l'une des réponses de l'IA avec une erreur, vous ouvrez le tracing de la réponse et vous pouvez l'explorer plus en détail pour trouver la cause profonde.

Trouvez la cause profonde plus rapidement avec les informations détaillées sur les traces

New Relic AI Monitoring élimine les approximations des applications d'IA complexes. Notre vue du tracing des réponses révèle tout le parcours de votre demande d'IA, de la saisie par l'utilisateur d'origine jusqu'à la réponse finale. New Relic AI Monitoring capture également diverses métadonnées associées à chaque demande. En cliquant sur les spans, vous pouvez accéder aux métadonnées telles que le nombre de jetons, les informations sur le modèle et les messages échangés au cours des appels de modèle, ce qui permet un débogage granulaire.

Notre intégration avec LangChain permet le tracing étape par étape, montrant ainsi le traitement de la saisie sur les différents composants de l'IA ainsi que la génération des sorties. Cette capacité de débogage très fin est inestimable pour le dépannage d'applications d'IA complexes.

Vous souvenez-vous du scénario d'erreur dans notre service de chat ? Si vous cliquez sur le span problématique au sein de la trace, vous obtenez les informations détaillées sur l'erreur. Ceci vous permet de rapidement diagnostiquer et résoudre la cause profonde du problème et de remettre votre application d'IA sur les rails en un rien de temps.

Optimisez les performances et les coûts sur tous vos modèles

Le choix du bon modèle d'IA pour votre application est crucial. Mais avec un nombre croissant d'options, comment pouvez-vous être sûr de faire le meilleur choix ? Heureusement, le comparatif des modèles d'IA de New Relic AI Monitoring est là pour vous guider en vous fournissant des informations détaillées et précieuses sur les performances et le coût des différents modèles d'IA. Vous pouvez ainsi prendre une décision éclairée sur le modèle qui répond le mieux à vos besoins.

Pour la simple application de chat, voici comment utiliser le comparatif des modèles d'IA en quelques clics :

- Depuis New Relic, naviguez jusqu'à AI Monitoring.

- Dans la section Capability, cliquez sur Compare Models.

- Choisissez les modèles que vous souhaitez comparer, GPT-4 et Bedrock, par exemple.

- Cliquez sur See the Comparison pour afficher les résultats détaillés de la comparaison, puis sélectionnez le modèle qui convient le mieux pour votre service de chat.

Amélioration de la sécurité des données et de la confidentialité des utilisateurs

Chez New Relic, nous comprenons l'importance de la protection des données sensibles. C'est pourquoi New Relic AI Monitoring offre des fonctionnalités de sécurité robustes pour assurer la conformité et la confidentialité des utilisateurs. La fonctionnalité de filtres de suppression (Drop Filters) vous permet d'exclure de manière sélective certains types de données (telles que les renseignements personnels) du monitoring, alors que notre option d'opt-out complet vous donne le contrôle final sur la transmission des données et vous permet ainsi de désactiver l'envoi de prompts et de réponses via la configuration de l'agent.

Le paramétrage des filtres de suppression est simple. Dans AI Monitoring, naviguez simplement jusqu'à la section Drop Filters. Là, vous pouvez alors créer des filtres en utilisant des requêtes dans le langage NRQL de New Relic pour cibler des types de données spécifiques parmi les six événements proposés.

Étapes suivantes

Lancez-vous dès aujourd'hui

New Relic AI Monitoring vous permet de parcourir en toute confiance le paysage en constante évolution de l'IA. Avec l'onboarding aisé et la visibilité complète, vous pouvez rapidement optimiser vos applications d'IA en termes de performances, qualité et coût. Que vous soyez un développeur full-stack chevronné ou que vous commenciez tout juste votre parcours, New Relic AI Monitoring fournit les outils et les informations détaillées dont vous avez besoin pour libérer le plein potentiel de vos initiatives avec l'IA. Inscrivez-vous pour obtenir un compte New Relic gratuit et découvrez toute la puissance du monitoring de l'IA dès aujourd'hui.

Les opinions exprimées sur ce blog sont celles de l'auteur et ne reflètent pas nécessairement celles de New Relic. Toutes les solutions proposées par l'auteur sont spécifiques à l'environnement et ne font pas partie des solutions commerciales ou du support proposés par New Relic. Veuillez nous rejoindre exclusivement sur l'Explorers Hub (discuss.newrelic.com) pour toute question et assistance concernant cet article de blog. Ce blog peut contenir des liens vers du contenu de sites tiers. En fournissant de tels liens, New Relic n'adopte, ne garantit, n'approuve ou n'approuve pas les informations, vues ou produits disponibles sur ces sites.