O cenário da IA está evoluindo rapidamente. Novos modelos de IA poderosos como Sora, Mistral Next e Gemini 1.5 Pro estão empurrando os limites do que é possível. Empresas em todos os lugares estão ávidas por aproveitar esses avanços e criar experiências revolucionárias para os clientes.

Na New Relic, entendemos o potencial imenso da IA generativa e é por isso que criamos o New Relic AI, uma solução de IA generativa feita para democratizar a observabilidade. Nossa vasta experiência no desenvolvimento do New Relic AI nos proporcionou um entendimento profundo sobre os desafios inerentes e a necessidade crítica de soluções de monitoramento de IA robustas. É por isso que apresentamos o New Relic AI Monitoring, a primeira solução de monitoramento do desempenho de aplicativos (APM) do setor para IA que fornece visibilidade inigualável de todo o stack do aplicativo de IA.

Mas o New Relic AI Monitoring não é só nosso, é de todos! Queremos capacitar organizações de todos os tamanhos a embarcarem nas suas jornadas de IA com confiança. É por isso que estamos animados em anunciar a disponibilidade geral do New Relic AI Monitoring. Essa nova adição poderosa às mais de 30 funcionalidades da plataforma New Relic capacita você a monitorar, gerenciar e otimizar seus aplicativos de IA em termos de desempenho, qualidade e custo.

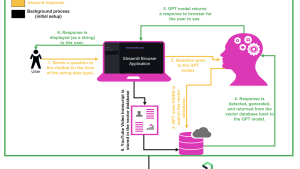

Nesta publicação do blog, usaremos um serviço de chat simples, criado com grandes modelos de linguagem (LLM) do OpenAI e LangChain para demonstrar o poder do New Relic AI Monitoring. Analisaremos seus recursos e orientaremos você sobre como utilizá-lo para resolver bugs na resposta do seu aplicativo de IA.

Instrumentação e integração sem esforço

Com as funcionalidades de instrumentação automática do New Relic, integrar o monitoramento de IA aos seus fluxos de trabalho é simples e intuitivo. Não importa se você está usando frameworks de IA como OpenAI ou Amazon Bedrock, nossos agentes fornecem uma instrumentação fácil nas linguagens Python, Node.js, Ruby, Go e .NET. Com um processo de instalação guiada, você pode definir a instrumentação para monitorar seu aplicativo de chat em poucos cliques, garantindo que esteja equipado para monitorar seus aplicativos de IA desde o início.

Pegue, por exemplo, o serviço de chat simples. Você pode começar assim:

- No New Relic, navegue até Add Data e selecione AI Monitoring.

- Sob AI Monitoring, escolha o framework que você quer monitorar, por exemplo, OpenAI Observability.

- Selecione o agente de instrumentação (neste caso, Python) e siga as instruções claras passo a passo para concluir a instrumentação.

Obtenha insights instantâneos sobre o uso dos modelos

Gerenciar e otimizar os modelos de IA pode ser complexo, mas o Inventário de modelos de IA simplifica o processo oferecendo uma visualização unificada e abrangente do seu uso dos modelos. Com visibilidade completa das principais métricas para todos os seus modelos, fica fácil isolar e resolver problemas de desempenho, erro ou relacionados a despesas.

Veja como você pode usar o Inventário de modelos de IA:

- No New Relic, navegue até AI Monitoring.

- Na seção capacidade, selecione Model Inventory.

- A aba Overview oferece um resumo de todas as solicitações, tempos de resposta, uso de token, conclusões e taxas de erros nos modelos para todos os serviços e contas. Clique em qualquer conclusão na tabela de conclusões para acessar a visualização de trace profundo, onde você pode visualizar todo o fluxo, da solicitação até a reposta.

- Clique na aba Errors para visualizar os erros em todos os modelos. Agora você pode isolar facilmente os erros e modelos mais comuns com as taxas de erros mais altas, facilitando a análise da causa raiz eficiente e a resolução mais rápida.

- Depois, clique na aba Performance para visualizar o número total de solicitações e o tempo de resposta por modelo. Isso permite que você identifique e otimize rapidamente os modelos de baixo desempenho.

- Clique na aba Cost para visualizar o uso de token por modelo, assim como o prompt e o uso de token concluído por modelo, ajudando você a identificar as oportunidades de redução de despesas.

- Utilize os filtros de dados para refinar sua análise por serviço, solicitação ou resposta. Isso permite que você obtenha insights mais profundos e ajuda a personalizar as suas análises para necessidades específicas, aprimorando sua capacidade de gerenciar e otimizar seus modelos de IA com eficiência.

Ao utilizar o AI Model Inventory, você consegue garantir que seus modelos de IA funcionem da forma ideal, mantenham alta segurança e operem de maneira econômica, oferecendo uma fundação robusta para as suas iniciativas orientadas por IA.

Visibilidade full-stack para aplicativos de IA

Assim que seu aplicativo de IA for instrumentado, o AI Monitoring da New Relic fornece visibilidade inigualável sobre seu desempenho e comportamento. O AI Monitoring da New Relic vai além do monitoramento do desempenho de aplicativos (APM) tradicional, integrando-se perfeitamente ao APM 360. Essa combinação poderosa fornece uma visão unificada do seu ecossistema de IA, proporcionando as métricas de APM padrão que você espera (tempo de resposta, taxas de transferência, taxa de erros) e métricas específicas de IA, como total de solicitações, tempo médio de resposta e uso de tokens, tudo fundamental para a otimização do seu aplicativo de IA. Isso capacita você a monitorar todo seu ambiente de IA com eficiência em uma só interface.

Vamos ver isso em ação para o serviço de chat.

- Na New Relic, navegue até AI Monitoring.

- Clique em AI Entity e selecione seu serviço de chat.

- A visão resumida exibe as métricas do aplicativo e de IA lado a lado.

No widget AI Response na visão resumida, você pode ver que o serviço de chat processou um total de 2,83K de respostas com um tempo médio de resposta de 7,1 segundos e uso médio de tokens de 858 tokens por resposta.

Identifique outliers nas respostas de IA com rapidez

Entender e analisar as respostas de IA é muito fácil com o AI Monitoring da New Relic. Com uma visão consolidada das respostas de IA, você pode identificar rapidamente outliers e tendências nas respostas de LLM, lhe permitindo ajustar seu aplicativo para que tenha o melhor desempenho, qualidade e custo.

Aqui, podemos analisar o feedback e sentimento de cada resposta de IA, além de filtrar por vários critérios, como solicitação, resposta, erros e muito mais

Você pode acessar a visão AI Response de duas maneiras:

- No resumo de serviço: clique no widget AI Response para uma visão focada.

- Visão global: clique na navegação principal do AI Response para uma visão consolidada de todas as entidades de IA.

Para o serviço de chat, vamos clicar no widget AI Response na visão resumida. Na página AI Response, vamos filtrar por erros e observar todas as respostas de IA que têm um erro para o serviço de chat.

Ao clicar em uma das respostas de IA com erro, você irá para a visão Response Tracing, onde é possível detalhar ainda mais a causa raiz

Analise a causa raiz mais rapidamente com insights de trace aprofundados

O AI Monitoring da New Relic acaba com a adivinhação durante a resolução de bugs em aplicativos de IA complexos. Nossa visão de monitoramento de respostas revela toda a jornada da solicitação da sua IA, desde a inserção inicial do usuário até a resposta final. O AI Monitoring da New Relic também captura vários metadados associados a cada solicitação. Ao clicar em spans, você pode acessar metadados como contagem de tokens, informações do modelo e também visualizar mensagens trocadas durante chamadas de modelo, permitindo a depuração granular.

Nossa integração com o LangChain permite o tracing passo a passo, demonstrando como a entrada é processada através dos diferentes componentes de IA e como as saídas são geradas. Essa funcionalidade de resolução de bugs refinada e granular é inestimável para a resolução de problemas de aplicativos de IA complexos.

Lembra do cenário de erro em nosso serviço de chat? Ao clicar no span problemático no trace serão reveladas informações detalhadas do erro. Isso permite que você diagnostique e corrija rapidamente a causa raiz do problema, colocando seu aplicativo de IA de volta aos eixos sem demora.

Otimize o desempenho e custo em todos os modelos

Escolher o modelo de IA certo para seu aplicativo é crucial. Mas com um número cada vez maior de opções, como você pode ter certeza de que está selecionando a melhor delas? É aqui que a comparação de modelos de IA do AI Monitoring da New Relic entra em cena, fornecendo insights valiosos sobre o desempenho e custo de diferentes modelos de IA para ajudar você a tomar decisões bem informadas sobre o modelo certo que atenda às suas necessidades.

Saiba como utilizar a comparação de modelos de IA em poucos cliques para o aplicativo de chat simples:

- Na New Relic, navegue até AI Monitoring.

- Na seção de capacidade, cliquem em Compare Models.

- Escolha os modelos que deseja comparar, por exemplo, GPT-4 versus Bedrock.

- Clique em See the Comparison para ver os resultados detalhados e selecionar o modelo certo para seu serviço de chat

Segurança de dados aprimorada e privacidade do usuário

Na New Relic, entendemos a importância de proteger dados sensíveis. É por isso que o AI Monitoring da New Relic oferece recursos de segurança robustos para garantir a conformidade e a privacidade do usuário. Com a funcionalidade Drop Filter, você pode excluir tipos de dados selecionados (como informações de identificação pessoal ou PII) do monitoramento, enquanto nossa opção de recusa completa dá a você controle total sobre a transmissão, permitindo que desabilite o envio de prompts e respostas por meio da configuração do agente.

A definição dos filtros é um processo fácil. Na funcionalidade AI Monitoring, basta navegar até a seção Drop Filters. Você pode, então, criar filtros usando consultas em New Relic Query Language (NRQL) para atingir tipos de dados específicos nos seis eventos oferecidos.

Próximos passos

Comece já

O AI Monitoring da New Relic capacita você a navegar com confiança no cenário de IA em constante evolução. Com integração fácil e visibilidade abrangente, você pode otimizar rapidamente seus aplicativos de IA com relação a desempenho, qualidade e custos. Seja você um desenvolvedor de full-stack experiente ou que está apenas começando em sua jornada, o AI Monitoring da New Relic fornece as ferramentas e os insights necessários para você alcançar o verdadeiro potencial das suas iniciativas de IA. Crie uma conta gratuita da New Relic e experimente ainda hoje o poder do monitoramento de IA.

As opiniões expressas neste blog são de responsabilidade do autor e não refletem necessariamente as opiniões da New Relic. Todas as soluções oferecidas pelo autor são específicas do ambiente e não fazem parte das soluções comerciais ou do suporte oferecido pela New Relic. Junte-se a nós exclusivamente no Explorers Hub ( discuss.newrelic.com ) para perguntas e suporte relacionados a esta postagem do blog. Este blog pode conter links para conteúdo de sites de terceiros. Ao fornecer esses links, a New Relic não adota, garante, aprova ou endossa as informações, visualizações ou produtos disponíveis em tais sites.