El panorama de la IA está cambiando rápidamente. Nuevos y potentes modelos de IA como Sora, Mistral Next y Gemini 1.5 Pro superan los límites de lo posible. Los negocios en todas partes están deseando aprovechar estos avances para crear experiencias jamás vistas para sus clientes.

En New Relic, comprendemos el inmenso potencial de la IA generativa y por esa razón hemos creado New Relic AI, una solución de IA generativa que fue diseñada para democratizar la observabilidad. Nuestra vasta experiencia en desarrollar New Relic AI nos permite gozar de una perspectiva profunda de los desafíos inherentes a los que nos enfrentamos y la necesidad crítica de contar con soluciones robustas de monitoreo de IA. Por eso hemos introducido el monitoreo New Relic AI, la primera solución de monitoreo del rendimiento de aplicaciones (APM) de la industria para IA que ofrece una visibilidad sin igual de todo el stack de aplicaciones de IA.

Pero el monitoreo New Relic AI no es solo para nosotros, ¡es para todo el mundo! Queremos que todas las organizaciones de todos los tamaños tengan la oportunidad de abrirse camino en la IA con plena confianza. Por eso tenemos el gusto de anunciar que el monitoreo New Relic AI ya está disponible para todos. Esta poderosa y nueva adición a las más de 30 capacidades de la plataforma de New Relic te da la oportunidad de monitorear, administrar y optimizar tus aplicaciones de IA en relación al rendimiento, la calidad y los costos.

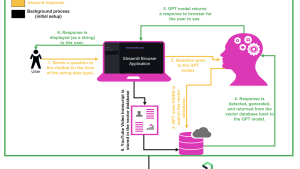

En esta publicación del blog, utilizaremos un servicio de chat sencillo diseñado con los modelos de lenguaje extensos (LLM) de OpenAI y LangChain para demostrar el poder del monitoreo New Relic AI. Vamos a explorar sus características y te explicaremos cómo aprovecharlo para depurar errores en la respuesta de tu aplicación de IA.

Instrumentación e integración sencillas

Gracias a las capacidades de instrumentación automática de New Relic, integrar el monitoreo de IA en tu flujo de trabajo es sencillo e intuitivo. Si usas frameworks de IA populares como OpenAI o Amazon Bedrock, nuestros agentes proporcionan una instrumentación impecable en los lenguajes Python, Node.js, Ruby, Go y .NET. A través de un proceso de instalación guiada, puedes configurar la instrumentación para monitorear tu aplicación de chat con solo unos clics, asegurándote de que estarás equipado para monitorear tus aplicaciones de IA desde el primer momento.

Veamos, por ejemplo, el sencillo servicio de chat. Puedes comenzar de esta manera:

- Ve a Add Data en New Relic y selecciona AI Monitoring.

- En AI Monitoring, elige el framework que deseas instrumentar, por ejemplo, OpenAI Observability.

- Selecciona el agente de instrumentación —en este caso, Python— y luego sigue paso a paso las instrucciones claras para completar la instrumentación.

Obtén información valiosa al instante sobre el uso de modelos

Gestionar y optimizar los modelos de IA puede ser complejo, pero AI Model Inventory simplifica el proceso ofreciendo una visión unificada y completa del uso de tus modelos. Con una visibilidad completa de las métricas clave de todos tus modelos, resulta sencillo aislar y solucionar problemas de rendimiento, errores o costos.

Puedes usar AI Model Inventory de la siguiente manera:

- En New Relic, ve a AI Monitoring.

- Bajo la sección de capacidad, selecciona Model Inventory.

- La pestaña Overview brinda un resumen de todas las solicitudes, tiempos de respuesta, uso de tokens, finalizaciones y tasas de errores en todos los modelos para todos los servicios y cuentas. Haz clic en cualquier finalización de la tabla de finalizaciones para acceder a la vista de trazado profundo, donde podrás ver todo el flujo desde la solicitud hasta la respuesta.

- Haz clic en la pestaña Errors para ver los errores en todos los modelos. Ahora puedes aislar fácilmente los errores más comunes y los modelos con las tasas de errores más elevadas, lo que facilita un análisis eficaz de la causa raíz y una resolución más rápida.

- Luego haz clic en la pestaña Performance para ver el número total de solicitudes y el tiempo de respuesta por modelo. Esto te permite identificar y optimizar rápidamente los modelos de bajo rendimiento.

- Haz clic en la pestaña Cost para ver el uso de tokens por modelo, así como el uso de tokens de solicitud y finalización por modelo, lo que te ayudará a identificar oportunidades de ahorro.

- Usa filtros de datos para refinar tu análisis por servicio, solicitud o respuesta. Esto te permite obtener más información valiosa y adaptar tu análisis a necesidades específicas, lo que te permitirá mejorar tu capacidad para gestionar y optimizar los modelos de IA con eficacia.

Al aprovechar AI Model Inventory, puedes asegurarte de que tus modelos de IA funcionen de forma óptima y rentable y mantengan una alta fiabilidad, lo que te brindará una base sólida para tus iniciativas impulsadas por la IA.

Visibilidad de todo el stack para las aplicaciones de IA

Una vez que tu aplicación de IA está instrumentada, New Relic AI Monitoring ofrece una visibilidad sin igual de su rendimiento y comportamiento. New Relic AI Monitoring trasciende el monitoreo del rendimiento de aplicaciones (APM) tradicional porque se integra a la perfección con APM 360. Esta combinación poderosa proporciona una vista unificada del ecosistema de IA, lo que te da no solo las métricas de APM estándar (tiempo de respuesta, rendimiento, tasa de errores) que esperas, sino que también te proporciona métricas exclusivas de IA como el total de solicitudes, el promedio del tiempo de respuesta y el uso de tokens, elementos todos que son clave para optimizar tu aplicación de IA. De esta manera podrás monitorear todo tu entorno de IA eficazmente en una sola interfaz.

Veámoslo en acción para el servicio de chat.

- En New Relic, ve a AI Monitoring.

- Haz clic en AI Entity y luego selecciona tu servicio de chat.

- La vista Summary muestra las métricas de la aplicación y de IA lado a lado.

Bajo el widget de respuesta de IA en la vista Summary, puedes ver que el servicio de chat ha procesado un total de 2,83 mil respuestas con un tiempo de respuesta promedio de 7,1 segundos y un promedio de uso de tokens de 858 tokens por respuesta.

Identifica los valores atípicos rápidamente en las respuestas de IA

Comprender y analizar las respuestas de IA es una tarea sencilla gracias a New Relic AI Monitoring. Gracias a la vista de respuestas de IA consolidada, puedes identificar rápidamente los valores atípicos y las tendencias en las respuestas de LLM, lo que te permitirá hacer los ajustes necesarios en tu aplicación para optimizar el rendimiento, la calidad y los costos.

Aquí podemos analizar los comentarios y el sentimiento para cada respuesta de IA, además de filtrar usando distintos criterios como solicitud, respuesta, errores y más.

La vista AI Response se puede acceder de dos maneras:

- En el resumen de servicio, haz clic en el widget AI Response para acceder a una vista enfocada.

- En la vista global, haz clic en la navegación principal de AI Response para acceder a una vista consolidada en todas las entidades de IA.

Para el servicio de chat, vamos a hacer clic en el widget de AI Response en la vista Summary. En la página AI Response, vamos a filtrar por error y vamos a ver todas las respuestas de IA que tienen un error para el servicio de chat.

Hacer clic en una de las respuestas de IA con un error te lleva a la vista de rastreo de la respuesta donde puedes profundizar más en busca de la causa raíz.

Identifica la causa raíz más rápido con información de rastreo profunda

Con New Relic AI Monitoring no tienes que estar adivinando a la hora de depurar aplicaciones de IA complejas. Nuestra vista de rastreo de respuesta deja ver todo el recorrido de la solicitud de IA, desde la entrada inicial del usuario hasta la respuesta final. New Relic AI Monitoring también captura diversos metadatos asociados con cada solicitud. Al hacer clic en los spans, puedes acceder a los metadatos como el recuento de tokens, la información del modelo y también ver los mensajes intercambiados durante las llamadas del modelo, lo que permite una depuración minuciosa.

Nuestra integración con LangChain permite contar con un rastreo paso a paso, demostrando cómo se procesa la entrada a través de los distintos componentes de IA y cómo se generan las salidas. Esta capacidad de depuración tan detallada es invaluable para detectar problemas en aplicaciones de IA complejas.

¿Recuerdas el escenario de error en nuestro servicio de chat? Hacer clic en el span problemático dentro de la traza revela información minuciosa sobre el error. Eso te permite diagnosticar y resolver rápidamente la causa raíz del problema y hacer que tu aplicación de IA reanude sus funciones sin perder tiempo.

Optimiza el rendimiento y los costos en todos los modelos

Elegir el modelo de IA idóneo para tu aplicación es un paso fundamental. Pero como todos los días aparecen más opciones, ¿cómo podemos asegurarnos de elegir la mejor opción? Aquí es donde la comparación de modelos de IA de New Relic AI Monitoring resulta útil, ya que proporciona información valiosa sobre el rendimiento y los costos de los distintos modelos de inteligencia artificial para ayudarte a tomar decisiones bien fundadas a la hora de elegir el modelo que mejor se ajuste a tus necesidades.

Para la aplicación de chat sencilla, así es como se puede utilizar la comparación de modelos de IA con solo unos cuantos clics:

- En New Relic, ve a AI Monitoring.

- Bajo la sección de capacidad, haz clic en Compare Models.

- Elige los modelos que deseas comparar, por ejemplo, GPT-4 frente a Bedrock.

- Haz clic en See the comparison para ver los resultados detallados y seleccionar el modelo más conveniente para tu servicio de chat.

Mejor seguridad de datos y privacidad del usuario

En New Relic, comprendemos la importancia de proteger los datos confidenciales. Por eso es que el monitoreo New Relic AI ofrece características de seguridad sólidas que sirven para garantizar el cumplimiento de las normas establecidas y la privacidad de los usuarios. Gracias a la funcionalidad de filtros de eliminación, puedes excluir del monitoreo los tipos de datos que tú decidas (como la información de identificación personal o PII). Por otro lado, nuestra opción para darse de baja completamente te da el control máximo de la transmisión de datos porque te permite desactivar el envío de invitaciones y respuestas a través de la configuración de agente.

Configurar los filtros de eliminación es fácil. Simplemente ve a la sección Drop Filters en la capacidad AI Monitoring. Allí podrás crear filtros usando las consultas de New Relic Query Language (NRQL) para excluir determinados tipos de datos dentro de los seis eventos que se ofrecen.

Próximos pasos

Comienza hoy mismo

New Relic AI Monitoring te da la oportunidad de navegar tranquilamente el siempre cambiante mundo de la IA. La integración sencilla y la visibilidad completa te permiten optimizar rápidamente tus aplicaciones de IA en función del rendimiento, la calidad y el costo. Tanto si eres un programador experto de todo el stack como si no tienes mucha experiencia, New Relic AI Monitoring te facilita las herramientas y la información que necesitas para lograr el verdadero potencial de tus iniciativas de IA. Regístrate para tener acceso a una cuenta de New Relic gratis y disfrutar ahora mismo del poder del monitoreo de IA.

Las opiniones expresadas en este blog son las del autor y no reflejan necesariamente las opiniones de New Relic. Todas las soluciones ofrecidas por el autor son específicas del entorno y no forman parte de las soluciones comerciales o el soporte ofrecido por New Relic. Únase a nosotros exclusivamente en Explorers Hub ( discus.newrelic.com ) para preguntas y asistencia relacionada con esta publicación de blog. Este blog puede contener enlaces a contenido de sitios de terceros. Al proporcionar dichos enlaces, New Relic no adopta, garantiza, aprueba ni respalda la información, las vistas o los productos disponibles en dichos sitios.