O cenário da IA está evoluindo constantemente com o surgimento de novos modelos como DeepSeek-R1, Deepseek-V3, Kimi K-1.5 e Qwen-2.5-max. Esses avanços estão democratizando o desenvolvimento da IA, permitindo que inovadores e desenvolvedores em todo o mundo tenham acesso a tecnologias de ponta sem os custos proibitivos tradicionalmente associados a esses avanços. No entanto, o número crescente de modelos disponíveis muitas vezes levanta questões críticas: qual modelo é mais adequado para um aplicativo específico? Como é possível avaliar o impacto da mudança para um modelo mais novo, de melhor desempenho ou mais econômico?

Para lidar com essas questões, é essencial ter ferramentas de monitoramento robustas que forneçam insights acionáveis sobre o desempenho, a qualidade e o custo dos aplicativos de IA. Isso permite que os desenvolvedores adotem ou façam a transição entre modelos de IA com confiança, minimizando os riscos.

Apresentamos o monitoramento do DeepSeek com o New Relic AI Monitoring

Estamos felizes em anunciar que a New Relic agora estende seu suporte de monitoramento de IA a modelos do DeepSeek, aumentando nossa cobertura atual de OpenAI, Claude e AWS Bedrock. Essa integração permite que os desenvolvedores aproveitem totalmente os recursos de código aberto e econômicos do DeepSeek, mantendo ao mesmo tempo uma visibilidade abrangente do desempenho do aplicativo.

Os modelos do DeepSeek ganharam atenção significativa devido à sua arquitetura inovadora e eficiência. Por exemplo:

- O modelo DeepSeek-R1 supera muitos modelos líderes de IA em tarefas de raciocínio, mantendo uma estrutura de custos significativamente menor.

- Sua arquitetura de combinação de especialistas (Mixture-of-Experts, MoE) ativa apenas submodelos relevantes para tarefas específicas, reduzindo a sobrecarga computacional sem comprometer o desempenho.

Com o New Relic AI Monitoring, você agora pode:

- Monitorar aplicativos criados em modelos DeepSeek em tempo real.

- Avaliar métricas principais, como desempenho, qualidade e custo.

- Obter insights sobre como esses modelos impactam a funcionalidade geral do seu aplicativo.

Por que escolher modelos do DeepSeek?

A DeepSeek surgiu como uma empresa formidável no espaço da IA ao fornecer modelos de alto desempenho por uma fração do custo exigido por concorrentes maiores, como OpenAI ou Google. Entre as principais características estão:

- Aprendizado por reforço: DeepSeek emprega técnicas avançadas de aprendizado por reforço para tarefas de raciocínio.

- Economia: modelos como o DeepSeek-R1 usam menos recursos durante treinamento e inferência, mantendo desempenho de última geração

- Acessibilidade de código aberto: ao contrário de muitos modelos proprietários, a natureza de código aberto do DeepSeek permite que os desenvolvedores personalizem e implantem localmente sem restrições

Esses atributos tornam o DeepSeek uma escolha atraente para empresas que buscam soluções de IA dimensionáveis sem incorrer em despesas exorbitantes.

Configurando e monitorando modelos do DeepSeek localmente com New Relic

Nesta publicação, vamos orientá-lo na configuração de um modelo DeepSeek localmente e em sua integração ao New Relic AI Monitoring para monitorar seu desempenho de forma eficaz.

1º passo: implantar um modelo DeepSeek localmente

- Como a DeepSeek lançou seu modelo localmente, você pode hospedá-lo, seja em uma máquina pessoal ou em um ambiente compartilhado.

- Uma maneira fácil de operar modelos do DeepSeek é usando Ollama, uma ferramenta para executar facilmente grandes modelos de linguagem de peso aberto.

- Primeiro, instale o Ollama usando seu instalador aqui.

- Em seguida, baixe um dos modelos do DeepSeek.

- Se você estiver apenas testando o DeepSeek, o modelo destilado do Llama de 8 bilhões de parâmetros deve atingir um bom equilíbrio entre desempenho e demandas de recursos. Execute ollama pull deepseek-r1:8b

- Em uma máquina de menor potência, ou se você quiser tentar economizar espaço em disco, tente o modelo Qwen menor de 1,5 bilhões de parâmetros ollama pull deepseek-r1:1.5b

- Por fim, execute seu modelo com ollama run deepseek-r1:8b (ou substitua pelo modelo Qwen se você o baixou). Isso iniciará por padrão um servidor de chat compatível com OpenAI em

http://localhost:11434/v1/chat/completions. - DeepSeek recomenda o uso do OpenAI SDK para interagir com seu modelo. Para configurar seu cliente, siga as instruções aqui.

2º passo: integração com o New Relic AI Monitoring

O DeepSeek usa uma API compatível com OpenAI e sugere o uso do OpenAI SDK em seu aplicativo. Portanto, monitoraremos o aplicativo exatamente como faríamos com um aplicativo que usa OpenAI diretamente.

Uma vez que o seu aplicativo for implantado:

- Obtenha uma conta gratuita na New Relic ou faça o login se você já tiver uma conta.

- Clique em Integrações e agentes.

- Na barra de pesquisa, digite OpenAI e selecione-o.

- Escolha a linguagem de programação (Python, Node.js) do seu aplicativo.

- Siga o processo de integração guiado fornecido pela New Relic. Esse processo vai orientá-lo sobre a instrumentação do seu aplicativo de IA desenvolvido com o DeepSeek. Chamamos o nosso exemplo de aplicativo de "deepseek-local".

3º passo: avaliação de desempenho, qualidade e custo

Uma vez que seu aplicativo for instrumentado, você pode começar a usar o AI Monitoring:

- Acesse o AI Monitoring: navegue até All Capabilities (Todos os recursos) no dashboard da New Relic e clique em AI Monitoring.

Recurso AI Monitoring em "All Capabilities"

- Selecione o exemplo de aplicativo: na seção AI Monitoring, em All Entities (Todas as entidades), selecione o exemplo de aplicativo deepseek-local desenvolvido usando DeepSeek e Ollama.

Exemplo de aplicativo Deepseek-local aparecendo na aba "AI entities"

- Ver resumo do APM 360: após navegar, você estará no resumo do APM 360. Essa tela fornece insights das principais métricas, como o número de solicitações, o tempo médio de resposta, o uso de tokens e as taxas de erros de resposta juntamente com os sinais clássicos de APM, insights de infraestrutura e logs. Você pode identificar rapidamente a origem dos problemas e fazer uma análise mais aprofundada.

Visão integrada do APM 360 e do AI Monitoring

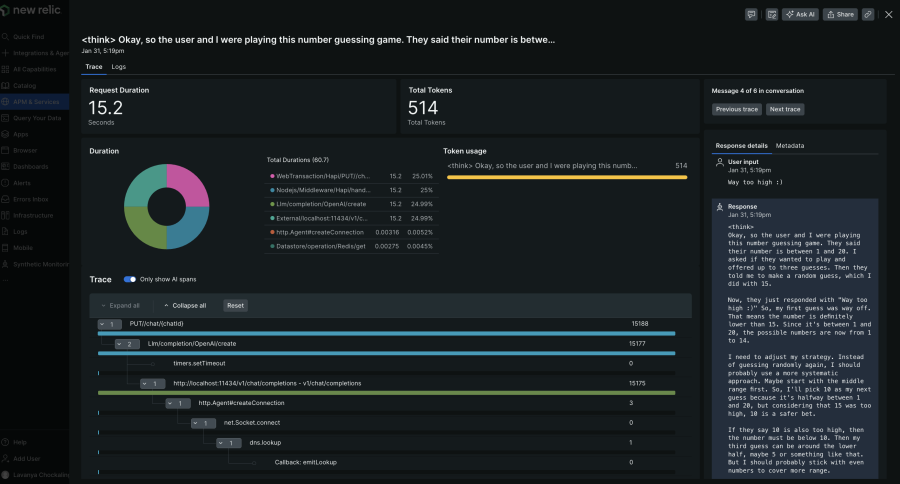

- Visualização de monitoramento profundo: para uma análise mais detalhada relacionada ao seu uso do DeepSeek, clique em AI responses (Respostas de IA) no resumo do APM 360 para ver todo o caminho, desde a entrada do usuário até a resposta final, incluindo metadados como contagem de tokens, informações do modelo e interações do usuário. Isso ajuda a identificar a raiz dos problemas rapidamente.

Tela de rastreamento de resposta de IA que fornece visibilidade de ponta a ponta da solicitação e da resposta

- Avaliação da qualidade do modelo: analisa as respostas do LLM para identificar e mitigar problemas como toxicidade, insultos e negatividade. Atualmente disponível na prévia limitada.

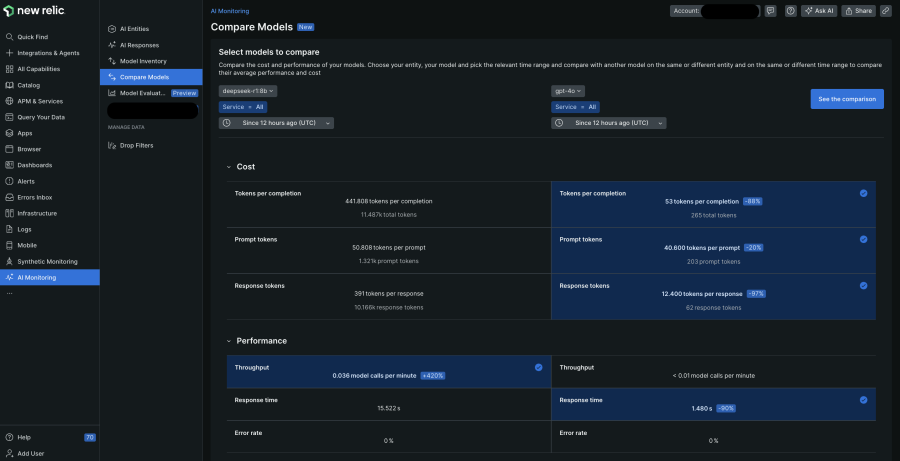

4º passo: comparar modelos para escolher o melhor

A comparação de modelos é uma parte fundamental do monitoramento de IA. Isso permite uma comparação simples dos modelos DeepSeek com outros modelos que você já usou, avaliando o desempenho e o custo para fazer a melhor escolha com base nas suas necessidades.

Tela de comparação de modelos exclusiva do AI Monitoring que mostra como dois modelos de IA se comparam em termos de desempenho e custo

5º passo: segurança e privacidade de dados

Para complementar a vantagem de segurança dos modelos DeepSeek hospedados localmente, a New Relic permite que você exclua o monitoramento de dados sigilosos (como informações de identificação pessoal ou PII) em seus pedidos e respostas de IA. Clique em Drop Filters e crie filtros voltados para os tipos de dados específicos dentro dos seis eventos oferecidos.

Conclusão

O surgimento de modelos inovadores de IA como o DeepSeek-R1 marca um momento crucial na democratização da inteligência artificial. Com ferramentas como New Relic AI Monitoring fornecendo suporte abrangente de monitoramento, os desenvolvedores podem explorar os novos horizontes com segurança e, ao mesmo tempo, garantir um desempenho otimizado do aplicativo.

Próximos passos

Cadastre-se para obter o New Relic AI Monitoring e mantenha-se à frente neste campo em rápida evolução enquanto continuamos expandindo o suporte para tecnologias de IA de ponta.

As opiniões expressas neste blog são de responsabilidade do autor e não refletem necessariamente as opiniões da New Relic. Todas as soluções oferecidas pelo autor são específicas do ambiente e não fazem parte das soluções comerciais ou do suporte oferecido pela New Relic. Junte-se a nós exclusivamente no Explorers Hub ( discuss.newrelic.com ) para perguntas e suporte relacionados a esta postagem do blog. Este blog pode conter links para conteúdo de sites de terceiros. Ao fornecer esses links, a New Relic não adota, garante, aprova ou endossa as informações, visualizações ou produtos disponíveis em tais sites.