In einer Event-gesteuerten Architektur können Anwendungen miteinander kommunizieren, indem sie Events erzeugen und darauf reagieren. Mitfahr-Apps nutzen beispielsweise Event-Streams, um Fahrtenbuchungen zu handhaben. Dabei lösen Events Dienste wie Routenplanung, Fahrerzuweisung und Zahlungsabwicklung aus. Ebenso werden auf E-Commerce-Plattformen Bestellungen über Events gesteuert, die das Inventar aktualisieren, Bestätigungs-E-Mails versenden, den Versand initiieren und Kundenkonten aktualisieren. Diese Art von Architektur ist also für digitale Erlebnisse ganz offensichtlich sehr wichtig. Da moderne Anwendungen allerdings zunehmend mit Nachrichtenwarteschlangen und Streamingdaten arbeiten, kann sich das Monitoring dieser komplexen Systeme schwierig gestalten. Immer größer werdende Event-Volumen erschweren das Debuggen von Problemen wie Bottlenecks, Drosselung und Datenlatenz, sodass sich Probleme oft erst bemerkbar machen, wenn Benutzer:innen davon betroffen sind.

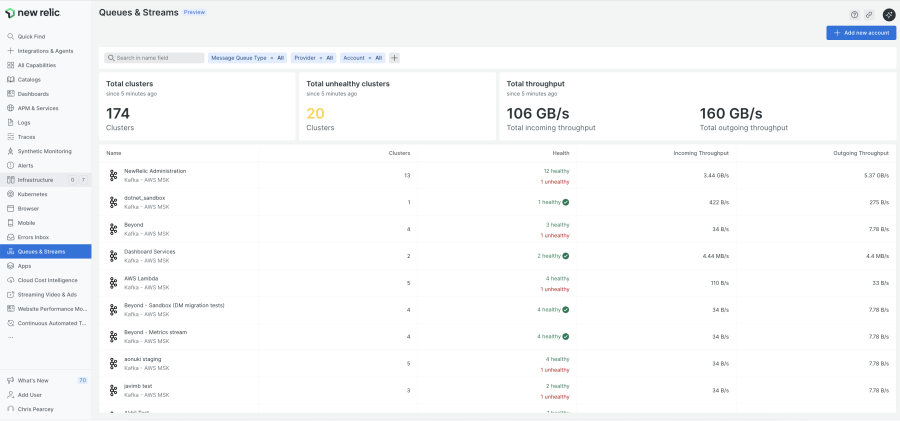

Wir freuen uns, heute New Relic Monitoring für Warteschlangen & Datenströme vorzustellen, die branchenweit erste vollständig integrierte Monitoring-Lösung, die bidirektionale Einblicke in Ihre gesamte Event-gesteuerte Architektur bietet. Dieses einzigartige, funktionsreiche Toolset bietet detaillierte Echtzeit-Einblicke in Kafka-Cluster und proaktives Monitoring mit vorgefertigten, sofort einsatzbereiten Alert-Bedingungen auf Basis von Trenddaten, wodurch die für andere Kafka-Monitoring-Lösungen typische Verzögerung von 2 Minuten kein Thema mehr ist.

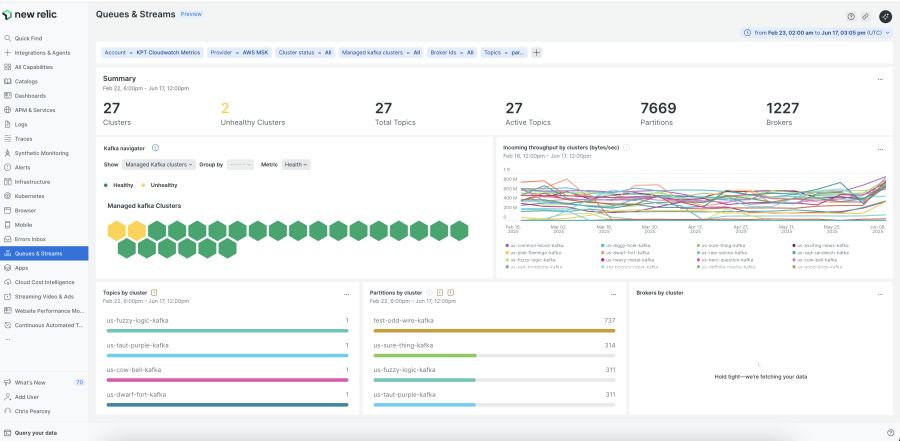

Zentrale Cluster-Ansicht: Kafka-Health sofort im Blick

New Relic Warteschlangen & Datenströme bietet durchgängige Transparenz mit Kontext für Nachrichtenwarteschlangen und Datenströme. Das Toolset verfügt über eine einzigartige bidirektionale Drilldown-Funktion, die Topics sowohl mit Producer- als auch mit Consumer-Services verbindet und DevOps-Teams in die Lage versetzt, Probleme wie langsame Producer, überbeanspruchte Topics oder auch überlastete Consumer schnell zu ermitteln und zu beheben. Die wichtigsten Features:

- Granulare Einblicke in die Kafka-Health auf allen Ebenen, bis hin zu Cluster, Partition, Broker, Topic, Producer und Consumer.

- Schnelle Ursachenfindung und Performance-Analyse mit den bidirektionalen Drilldown-Funktionen vom Service zum Topic und zurück.

- Proaktive Erkennung potenzieller Probleme dank einsatzfertiger Alert-Bedingungen und Echtzeit-Anomalieerkennung.

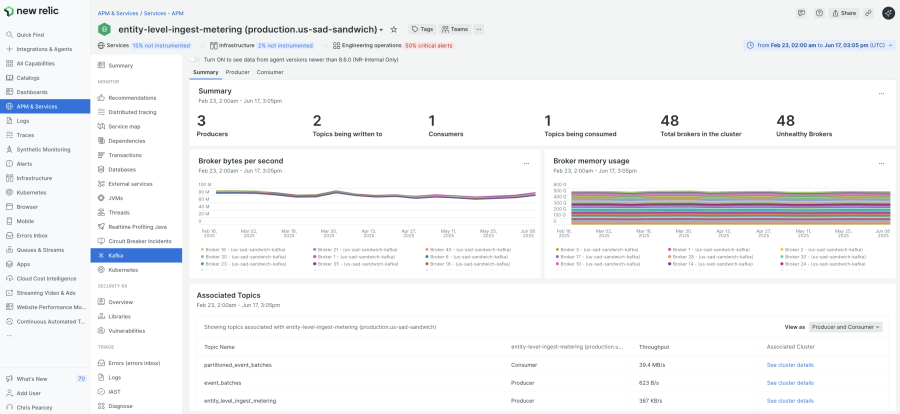

Schnelleres Troubleshooting mit bidirektionalen Drilldowns

Bei Problemen in nachrichtengesteuerten Anwendungen ist die Ursachenfindung oft die größte Schwierigkeit. Die bidirektionale Drilldown-Funktion von New Relic bietet nahtlose, korrelierte Echtzeit-Einblicke von Kafka-Clustern zu Producern und Consumern (APM-Services) – und wieder zurück. Dank der Visibility mit Kontext können Engineers schnell feststellen, ob das Problem auf überaktive Producer, träge Consumer oder Ressourcenbeschränkungen auf Broker-Seite zurückzuführen ist. So werden die mittlere Zeit bis zur Erkennung (MTTD; Mean time to detection) und die mittlere Zeit bis zur Auflösung (MTTR; Mean time to resolution) deutlich gesenkt, die Systemausfallsicherheit wird verbessert und ein nahtloser Datenfluss über verteilte Architekturen hinweg kann gewährleistet werden.

Sofortige Anomalieerkennung und proaktives Alerting

Das Monitoring von Kafka-Streams ist oft mit Verzögerungen behaftet, die ein sofortiges Handeln verhindern. New Relic schafft durch Echtzeit-Kafka-Metriken über unseren Java Agent Abhilfe und versetzt Ihre Teams in die Lage, Anomalien bei allen Kafka-Client-Komponenten sofort zu erkennen, ob Producer oder Consumer. Das in Kürze verfügbare proaktive Alerting verbessert das Monitoring zusätzlich, da es die Kafka eigene Verzögerung beim Monitoring umschifft und Ihr Team sofort über potenzielle Probleme informiert, bevor diese eskalieren.

Ermittlung und Optimierung des Daten-Throughputs

Ein effizienter Datenfluss ist ein wesentlicher Performance-Faktor. New Relic liefert detaillierte Einblicke in Metriken wie Latenz, Drosselungsraten, Warteschlangentiefe und die Anzahl wiederholter Versuche, sodass Ihr Team Bottlenecks, die den Throughput beeinträchtigen, schnell lokalisieren können. Zusätzlich erkennt unsere Lösung unkomprimierte Datenströme, sodass Sie Ihr System mit effektiven Komprimierungsstrategien optimieren und die Gesamtleistung verbessern können.

Umfassende Einblicke in Kafka-Topics

Es ist wichtig, über die Performance einzelner Topics im Bilde zu sein. Dank der detaillierten Topic-Ansicht von New Relic können Benutzer:innen schnell auf die 20 wichtigsten Topic-Entities in ihren Clustern mitsamt Echtzeit-Metriken wie eingehender und ausgehender Throughput und Nachrichtenraten zugreifen. Durch diese Detailtiefe wird sichergestellt, dass Teams die Topic-Performance und Ressourcenzuweisung effektiv verwalten und optimieren können.

Die ersten Schritte

So einfach lässt sich das Monitoring von Warteschlangen und Datenströmen in Ihren Workflow integrieren:

Schritt 1: Integration einrichten

- Wählen Sie Ihren Kafka-Anbieter (Amazon MSK oder Confluent Cloud) und folgen Sie der geführten Installation.

Schritt 2: New Relic UI aufrufen

- Melden Sie sich bei New Relic an und gehen Sie zu one.newrelic.com > All capabilities > Queues & Streams.

- Mit den intuitiven Filter- und Suchfunktionen können Sie Kafka-Cluster schnell identifizieren.

Schritt 3: Monitoring und Diagnose

- Verwenden Sie den visuellen Kafka Navigator, um rasch herauszufinden, welche Cluster Probleme aufweisen und welche nicht.

- Für detailliertere Metriken und die Korrelation mit Ihren APM-Services können Sie einen Drilldown ausführen.

Eine ausführliche Setup-Anleitung finden Sie in unserer Dokumentation zu New Relic Warteschlangen und Datenströmen.

Nächste Schritte

Sie möchten nun auch ungeahnte Visibility in Ihre nachrichtengesteuerten Anwendungen bringen? Registrieren Sie sich noch heute für ein kostenloses New Relic Konto. Damit erhalten Sie 100 GB zur kostenlosen Datenerfassung, unbegrenzte Basic-Lizenzen und sofortigen Zugriff auf unsere funktionsstarken Toolsets für das Warteschlangen- und Datenstrom-Monitoring.

Erfahren Sie mehr über dieses leistungsstarke Monitoring-Tool und sorgen Sie dafür, dass Ihre verteilten Anwendungen stets Top-Performance liefern.

Die in diesem Blog geäußerten Ansichten sind die des Autors und spiegeln nicht unbedingt die Ansichten von New Relic wider. Alle vom Autor angebotenen Lösungen sind umgebungsspezifisch und nicht Teil der kommerziellen Lösungen oder des Supports von New Relic. Bitte besuchen Sie uns exklusiv im Explorers Hub (discuss.newrelic.com) für Fragen und Unterstützung zu diesem Blogbeitrag. Dieser Blog kann Links zu Inhalten auf Websites Dritter enthalten. Durch die Bereitstellung solcher Links übernimmt, garantiert, genehmigt oder billigt New Relic die auf diesen Websites verfügbaren Informationen, Ansichten oder Produkte nicht.